Künstliche Intelligenz ist ein Zweig der Informatik, der darauf abzielt, Systeme zu schaffen, die Aufgaben ausführen können, die normalerweise die menschliche Intelligenz erfordern, wie z. B. logisches Denken, Interpretation oder Entscheidungsfindung. Mithilfe von Techniken wie maschinellem Lernen und der Verarbeitung natürlicher Sprache. Durch die Kombination von Mathematik, Informatik und Sprachwissenschaft revolutioniert die KI ganze Branchen, vom Gesundheitswesen über das Finanzwesen bis hin zur digitalen Kreativität. Doch was verbirgt sich wirklich hinter diesem neuen Konzept, das mittlerweile unumgänglich geworden ist?

Wie kann ein Computer mich verstehen und mir antworten?

Jahrzehntelang schien die Vorstellung von einem Computer, der sprechen und unsere Sprache verstehen kann, Science-Fiction zu sein. Doch heute ist diese Vision dank der spektakulären Fortschritte in der Informatik und der Verarbeitung natürlicher Sprache (NLP) Realität geworden.

Wenn wir von natürlicher Sprache sprechen, geht es um die Art und Weise, wie wir Menschen kommunizieren: nuancierte Sätze voller Mehrdeutigkeiten, Emotionen und manchmal sogar Widersprüche. Damit ein Computer diese komplexe Sprache erfassen kann, reicht es nicht aus, einfach ein Wörterbuch zu programmieren. Er muss lernen, wie wir zu denken oder zumindest die grammatikalischen Strukturen, den kulturellen Kontext und die Absichten hinter jedem Wort zu erkennen.

Neuere Modelle wie Gemini oder ChatGPT nutzen Milliarden von Textdaten, um zu lernen, wie man auf natürliche und kontextbezogene Weise antwortet.

Natürlich ist das Verständnis der menschlichen Sprache durch Computer nicht perfekt. Kulturelle Nuancen, idiomatische Ausdrücke und sogar Humor stellen nach wie vor Hindernisse dar.

1950: Ein experimenteller Test und die Entdeckung der ersten KI

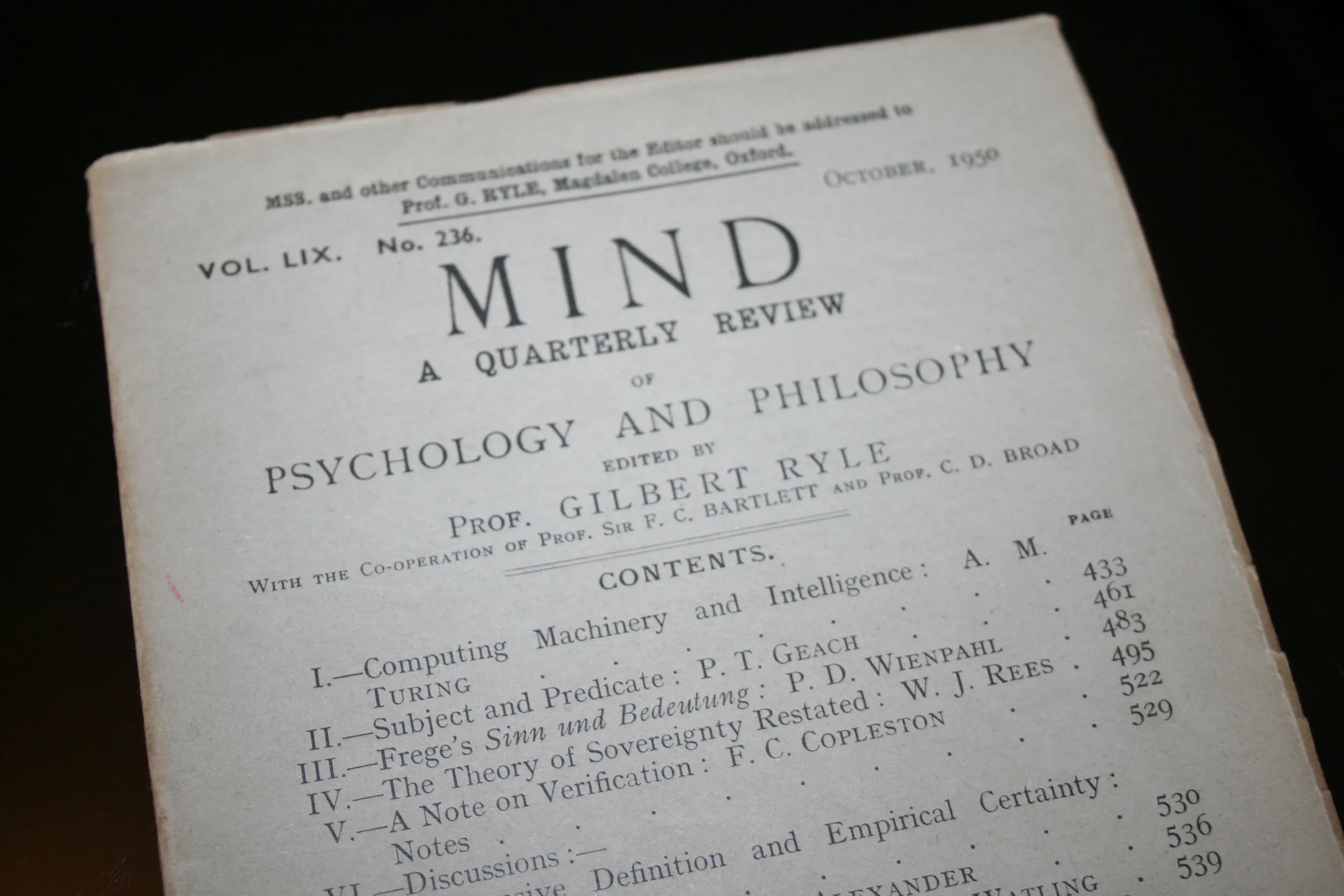

Die Geschichte der Computer, die die natürliche Sprache des Menschen verstehen können, reicht bis in die 1950er Jahre zurück, als der britische Mathematiker Alan Turing einen Artikel mit dem Titel Computing Machinery and Intelligence veröffentlichte, in dem er den berühmten „Turing-Test“ vorschlug. Mit diesem Test soll festgestellt werden, ob eine Maschine intelligentes Verhalten an den Tag legen kann, das von dem eines Menschen nicht zu unterscheiden ist, indem ihre Fähigkeit bewertet wird, ein Gespräch in natürlicher Sprache zu beginnen.

Diese Idee inspirierte viele Forscher, darunter Joseph Weizenbaum, der 1966 am MIT das Programm ELIZA entwickelte. ELIZA simuliert eine Konversation, indem es die Rolle eines Rogers-Therapeuten übernimmt und auf die Nutzer reagiert, indem es ihre Aussagen in Form von Fragen neu formuliert. Obwohl ELIZA auf einfachen Musterabgleichsregeln basiert, demonstriert es die Machbarkeit von Mensch-Maschine-Interaktionen in natürlicher Sprache und löst damit sowohl Faszination als auch Debatten über die Grenzen des tatsächlichen Verstehens durch Maschinen aus.

2011: Google Brain im Dienste der Online-Suche

Im Jahr 2011 startete Google das Projekt Google Brain, eine ehrgeizige Initiative zur Erforschung des Potenzials von künstlicher Intelligenz (KI) und tiefen neuronalen Netzen. Das Projekt, das als Zusammenarbeit zwischen Google und Forschern aus Stanford begann, entwickelte sich schnell zu einer zentralen Säule der technologischen Innovation bei Google.

Von Anfang an hatte Google Brain einen bedeutenden Einfluss auf eines der wichtigsten Produkte des Unternehmens: die Suchmaschine.

Das Hauptziel von Google Brain bestand darin, die Grenzen der Technologie durch die Kombination von Deep Learning mit der massiven Rechenleistung von Google zu erweitern. Die Idee war, Algorithmen zu verwenden, die dem menschlichen Gehirn nachempfunden sind, um Daten in einem nie dagewesenen Ausmaß zu analysieren, zu verstehen und zu interpretieren.

Mit der Anwendung dieser Technologie auf die Suchmaschine wollte Google die Relevanz der Ergebnisse verbessern und die Absichten der Nutzer verstehen, selbst wenn ihre Suchanfragen mehrdeutig oder schlecht formuliert waren.

2022: ChatGPT Konversationelle künstliche Intelligenz

ChatGPT, entwickelt von OpenAI, ist ein fortschrittliches Modell der generativen künstlichen Intelligenz, das darauf ausgelegt ist, mit Nutzern über natürliche Konversationen zu interagieren. Es basiert auf der GPT-Technologie (Generative Pre-trained Transformer) und ist in der Lage, Text in vielen Sprachen und zu einer Vielzahl von Themen zu verstehen und zu generieren.

ChatGPT zeichnet sich in verschiedenen Bereichen aus: Verfassen von Artikeln, Erstellen von Marketinginhalten, technische Unterstützung, Erklären komplexer Konzepte und sogar als Assistent für Computercodes. Seine Fähigkeit, sich an den erforderlichen Tonfall und Stil anzupassen, macht ihn zu einem besonders nützlichen Werkzeug für Berufstätige, Studenten und Content-Ersteller.

Das Modell beruht auf tiefem Lernen, das mit riesigen Mengen an Textdaten trainiert wird. Dank seines Pre-Training- und Fine-Tuning-Mechanismus kann es präzise, konsistente und oft kontextuell relevante Antworten liefern. Dadurch ist er in der Lage, ein fast menschliches Verständnis von Dialogen zu simulieren.

ChatGPT entstand aus OpenAIs umfangreicher Forschung zu Sprachmustern. OpenAI wurde 2015 von Persönlichkeiten wie Elon Musk und Sam Altman gegründet und hatte es sich zur Aufgabe gemacht, den Zugang zu künstlicher Intelligenz zu demokratisieren und gleichzeitig für ihre ethische Entwicklung zu sorgen.

Generative Pre-trained Transformer: Wie funktioniert KI?

Modelle vom Typ Generative Pre-trained Transformer (GPT) basieren auf der Transformer-Architektur, die ursprünglich in dem Artikel „Attention Is All You Need“ (Vaswani et al., 2017) eingeführt wurde. GPTs wurden damals als tiefe neuronale Netze betrachtet, die in der Lage sind, natürliche Sprache in großem Umfang zu analysieren und zu generieren. Sie werden als vortrainiert bezeichnet, weil sie zunächst riesigen Textmengen ausgesetzt werden (das ist die Pre-Training-Phase) und dann für verschiedene Aufgaben spezialisiert oder angepasst werden können (das ist die Fine-Tuning-Phase).

Ein wenig Hintergrund: Woher stammt die Idee für den Transformer?

Gehen wir ein paar Jahre zurück. Vor den Transformers wurde die natürliche Sprache mit klassischen Methoden wie rekurrenten Netzwerken (RNN, LSTM) oder statistischen Ansätzen verarbeitet. Diese Techniken funktionierten zwar, hatten aber Schwierigkeiten, sobald es darum ging, den Kontext langer Sätze zu verstehen. Je länger der Satz, desto schwieriger war es für die KI, den Überblick zu behalten. Das Ergebnis war eine gewisse Schwierigkeit bei der Verarbeitung komplexer Texte.

Anstatt die Wörter einzeln der Reihe nach zu verarbeiten, verwendet der Transformer einen Aufmerksamkeitsmechanismus, der es ihm ermöglicht, sich auf alle Teile eines Satzes gleichzeitig zu konzentrieren. Dadurch wird es viel einfacher, lange Textsequenzen zu verstehen und zu manipulieren, ohne dass sich die Maschine auf dem Weg dorthin verliert. Dieser Fortschritt hat die Situation verändert und den Weg für leistungsfähigere und vielseitigere Modelle geebnet.

Der große Wurf: Gigatonnen von Text schlucken

Wenn man von der Trainingsphase (oder Pre-Training) für ein GPT spricht, beschreibt man einen Prozess, bei dem die KI Milliarden von Wörtern durchforsten wird. E-Books, Blogartikel, Webseiten… Kurz gesagt: alles, was im Textformat zugänglich ist. Das Ziel? Die Regeln der Sprache zu erlernen, von der grundlegenden Grammatik bis hin zu stilistischen Feinheiten, ohne dass man sie auch nur mit dem Etikett „richtig/falsch“ versehen muss. Das nennt man Selbstkontrolle.

Das Prinzip ist einfach: In jedem Schritt wird GPT versuchen, das nächste Wort in einem Satz zu erraten, nur auf der Grundlage des vorherigen Kontextes. Man kann sich das wie ein gigantisches Ratespiel vorstellen, bei dem das Modell seine Statistiken durch aufeinanderfolgende Vorhersagen verfeinert. Nach und nach perfektioniert es seine Sprachkenntnisse, versteht die Zusammenhänge zwischen Wörtern und speichert ganz nebenbei eine Menge Informationen über die Welt (die es übrigens manchmal ungefiltert wieder ausspuckt!).

Fine-Tuning: Die Spezialisierung

Wenn GPT erst einmal riesige Textmengen verdaut hat, ist es bereits in der Lage, zusammenhängende Inhalte zu produzieren. Aber wir hören hier noch nicht auf. Es gibt noch eine weitere Phase des „fine-tuning“, in der man das Modell spezialisieren wird. Wenn wir zum Beispiel einen Chatbot für medizinische Hilfe wollen, werden wir ihn mit verifizierten Gesundheitsdaten fine-tunen, damit er genau und umsichtig antwortet.

Dieses Polieren kann auch durch „Reinforcement Learning with Human Feedback (RLHF)“ erfolgen, bei dem potenzielle Antworten menschlichen Bewertern gezeigt werden. Diese bewerten die Ergebnisse und die KI lernt, so nah wie möglich an den menschlichen Erwartungen zu kleben.