La inteligencia artificial sale poco a poco de la nube y se instala directamente en nuestros ordenadores. Gracias a un nuevo software diseñado para Windows, ahora es posible ejecutar una IA completa sin conexión a Internet, con la misma facilidad que un servicio en línea. Este avance redefine nuestra relación con la tecnología al combinar rendimiento, confidencialidad y autonomía. De este modo, el ordenador personal recobra todo su sentido al convertirse de nuevo en el centro de la inteligencia.

El mejor software local de IA y alternativas a ChatGPT para Windows

- ¿Qué es la IA local?

- 1. Ollama: ejecución local de modelos de IA

- 2. Jan AI: La aplicación local que convierte tu PC en un asistente inteligente.

- 3. LM Studio: una alternativa local a los servicios de IA en línea

- ¿Dónde puedo descargar modelos locales de IA para Windows?

- Los mejores modelos de IA para PC de gama media

¿Qué es la IA local?

La IA local es un software que puede ejecutarse directamente en tu ordenador, sin necesidad de un servidor remoto. A diferencia de servicios en línea como ChatGPT, que procesan tus solicitudes en la nube, una IA local realiza todos los cálculos en tu propio procesador o tarjeta gráfica. Esto la hace completamente independiente de Internet, ofreciendo una experiencia más privada y totalmente controlada.

Este enfoque está cambiando profundamente la forma en que interactuamos con la inteligencia artificial. Los intercambios ya no pasan por servidores externos, lo que elimina los riesgos asociados a la confidencialidad y las interrupciones del servicio. El coste de uso es cero una vez instalado el modelo, y la latencia es imperceptible porque las respuestas son generadas en tiempo real por el hardware del usuario.

Sin embargo, esta autonomía tiene sus limitaciones. Los modelos deben adaptarse a las capacidades de la máquina, su tamaño está limitado por la memoria disponible y su instalación requiere a veces algunos ajustes técnicos. No obstante, una vez configurada, la IA local se convierte en una herramienta potente y estable, capaz de competir con las soluciones en línea al tiempo que ofrece una gran libertad.

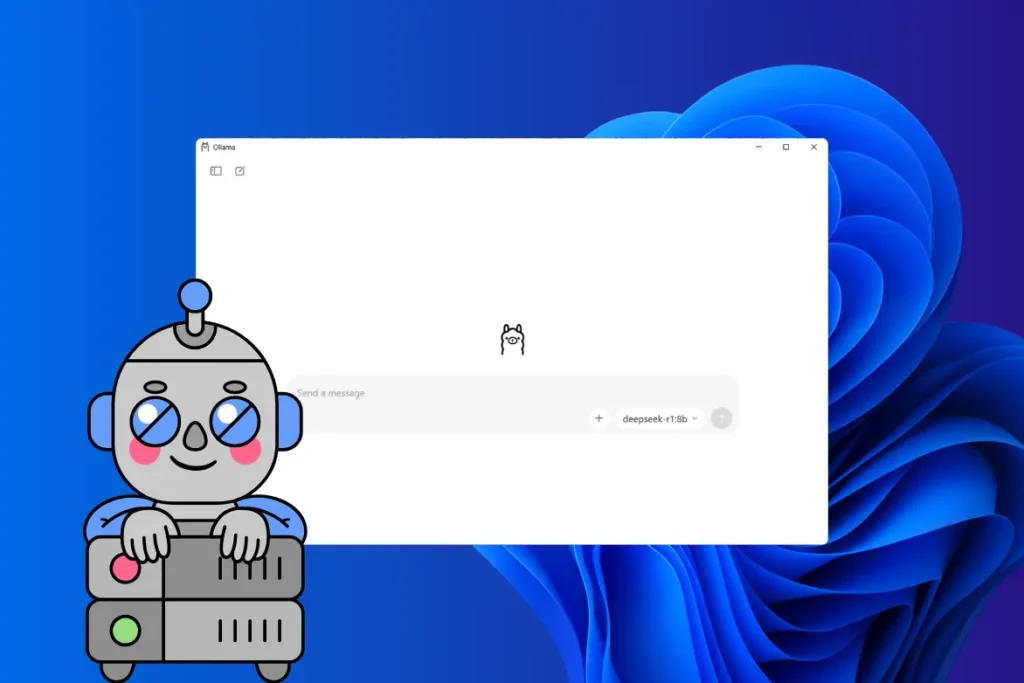

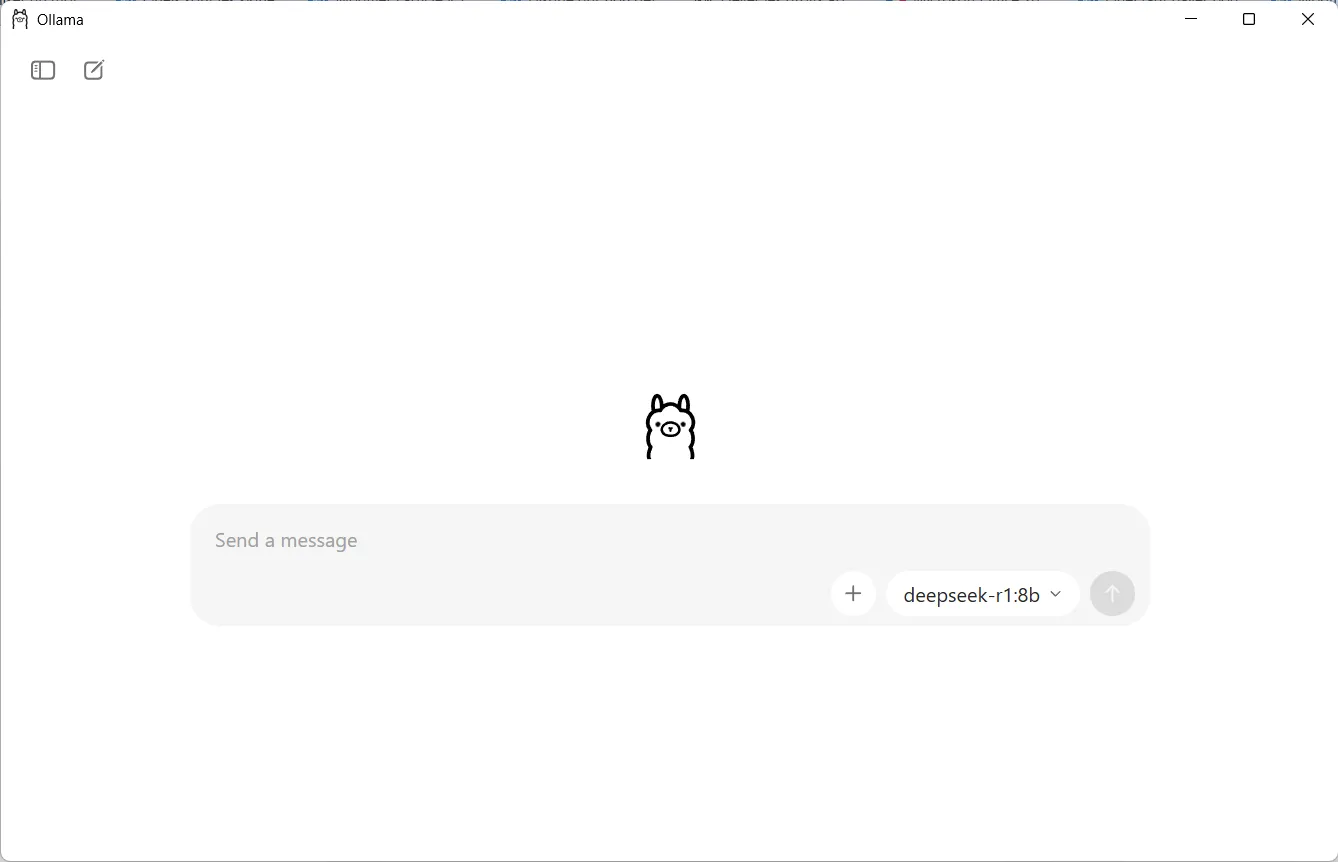

1. Ollama: ejecución local de modelos de IA

Ollama es una plataforma de código abierto diseñada para ejecutar modelos lingüísticos (LLM) directamente en un ordenador, sin depender de la nube. Compatible con Windows, macOS y Linux, permite descargar y utilizar localmente modelos como Llama 3, Mistral o Phi-3, al tiempo que ofrece una interfaz gráfica y de línea de comandos y una API local compatible con OpenAI. Gracias a su enfoque modular, Ollama gestiona automáticamente la descarga, cuantificación y lanzamiento de modelos, lo que facilita enormemente la creación de un entorno de IA privado, autónomo y seguro.

Para los usuarios técnicos, Ollama puede integrarse en los flujos de trabajo existentes para aplicaciones locales, herramientas de línea de comandos o servidores API. La ejecución se basa en el procesador o la GPU para acelerar la generación, y la compatibilidad con modelos cuantificados (formatos GGUF) permite obtener un buen rendimiento incluso en máquinas equipadas con tarjetas gráficas modestas. Esto convierte a Ollama en una solución ligera y de alto rendimiento para aprovechar la potencia de los modernos modelos de IA, al tiempo que se mantiene un control total sobre los datos y el hardware.

Sigue mi guía para usar ChatGPT-OSS localmente en Windows 11 con Ollama.

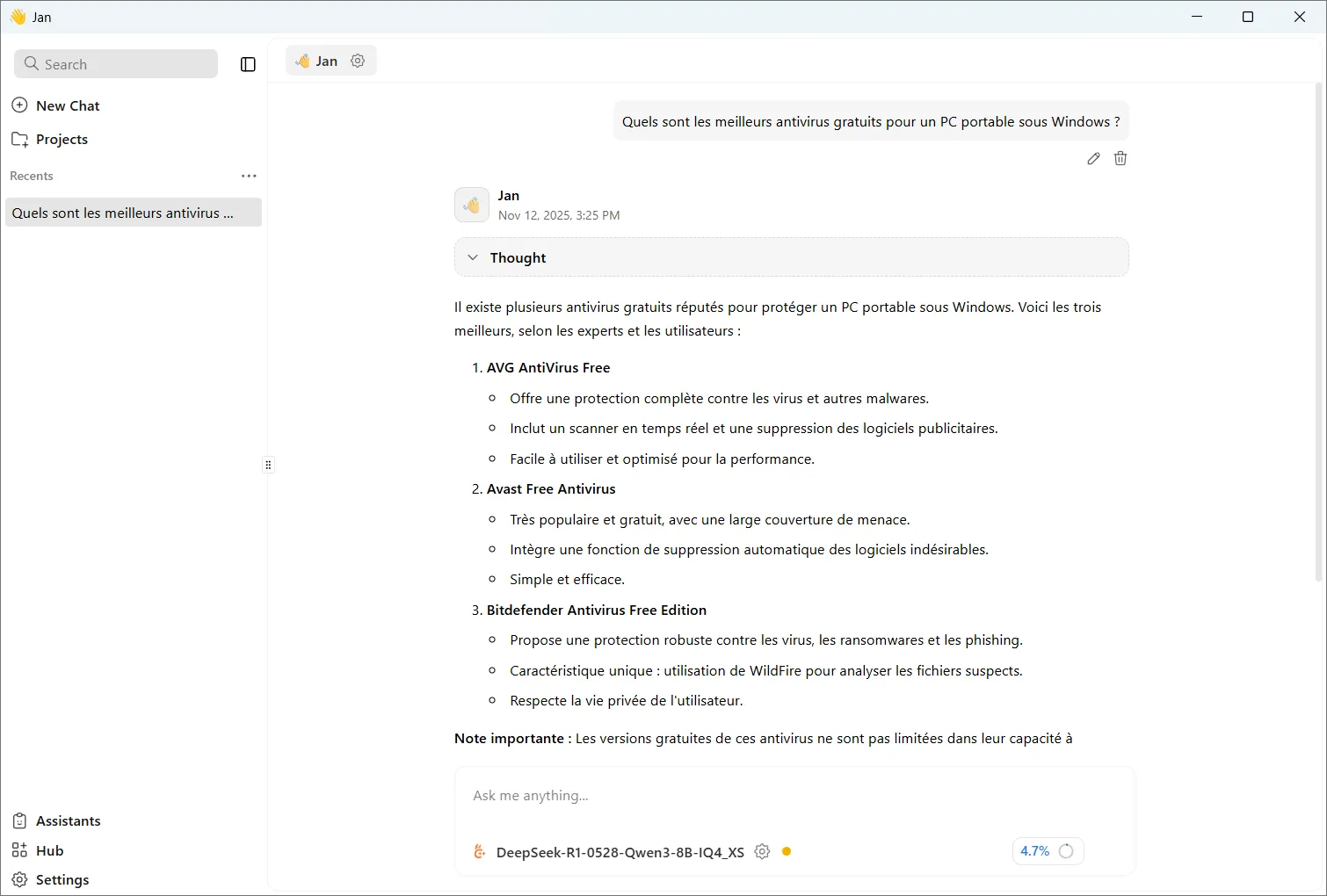

2. Jan AI: La aplicación local que convierte tu PC en un asistente inteligente.

Jan AI es una aplicación de código abierto diseñada para ofrecer a todo el mundo la posibilidad de ejecutar inteligencia artificial directamente en su ordenador. A diferencia de los servicios en línea, no depende de ninguna nube y funciona de forma totalmente local, garantizando la confidencialidad de los intercambios. Su cuidada interfaz permite descargar, gestionar y utilizar modelos lingüísticos avanzados como Llama, Mistral y Qwen, sin necesidad de utilizar la línea de comandos. En pocos minutos, un simple PC se convierte en una auténtica estación de trabajo capaz de generar textos, analizar datos o ayudar en la redacción, manteniendo el control sobre los recursos y la información procesada.

Detrás de su aparente sencillez, Jan AI incorpora una serie de funciones avanzadas, como la compatibilidad con modelos cuantificados (GGUF) para optimizar la memoria, la posibilidad de alternar entre el modo local y en la nube según sea necesario y la compatibilidad experimental con el protocolo RAG para interactuar con documentos. La aplicación aprovecha el procesador o la GPU para acelerar el procesamiento, adaptándose igualmente bien a portátiles y estaciones de trabajo equipadas con tarjetas NVIDIA o AMD. Al combinar portabilidad, confidencialidad y flexibilidad, Jan AI destaca como alternativa a las soluciones en la nube, capaz de ejecutar IA de alto rendimiento directamente desde el escritorio.

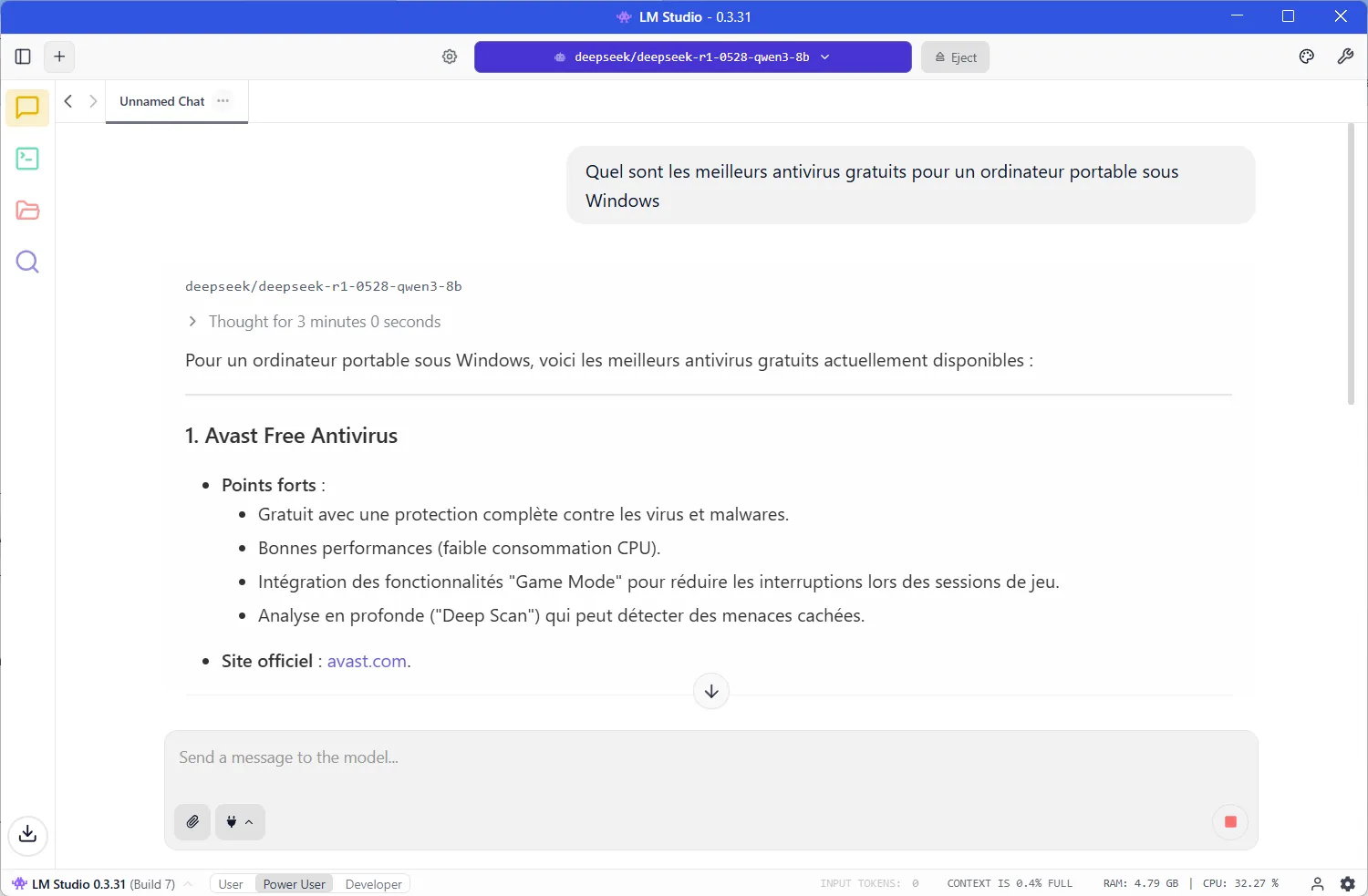

3. LM Studio: una alternativa local a los servicios de IA en línea

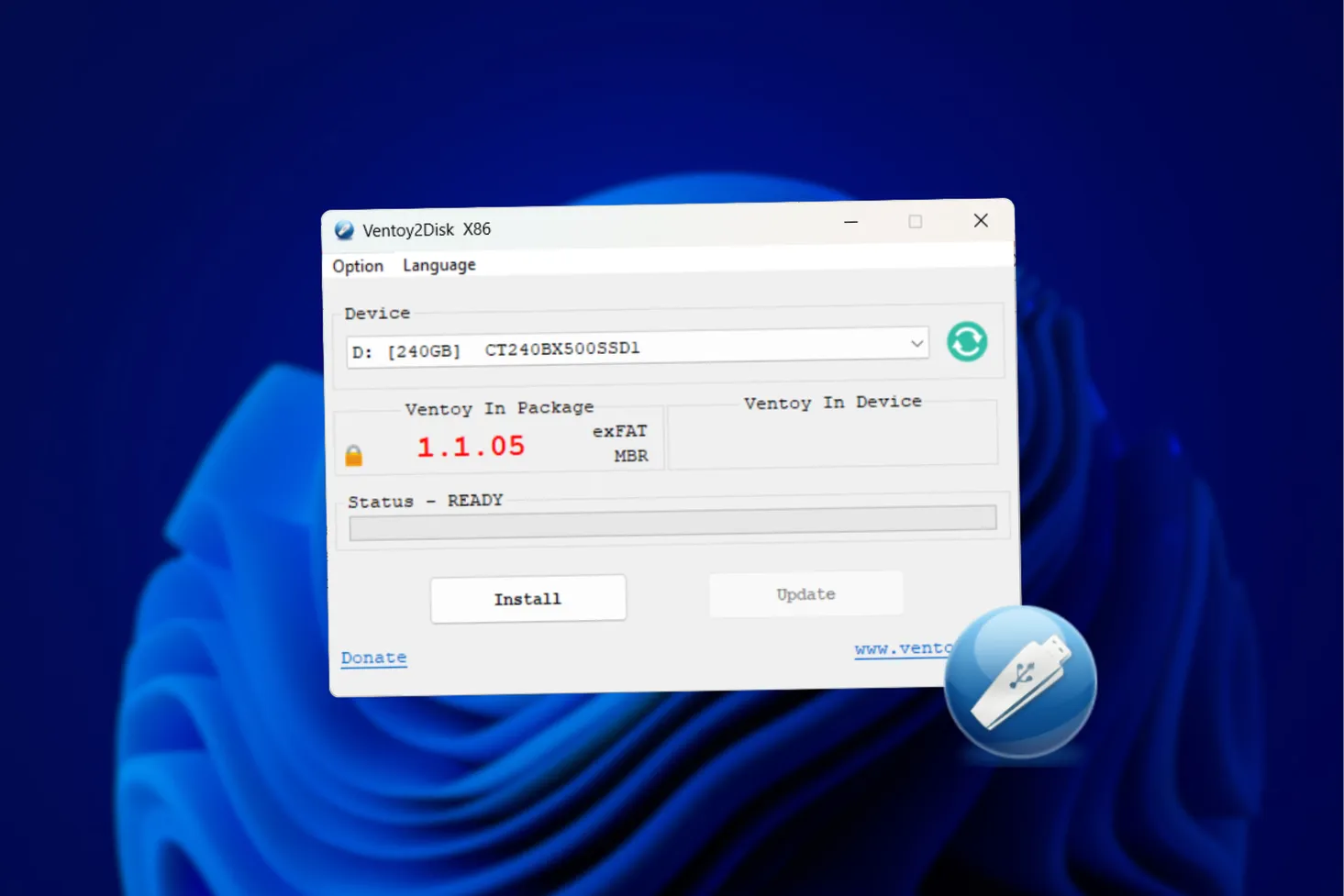

LM Studio es una moderna aplicación que permite ejecutar modelos de inteligencia artificial directamente en el ordenador, sin depender de un servicio en línea. Compatible con Windows, macOS y Linux, ofrece una interfaz que pone el uso de modelos como Llama 3, Gemma o Mistral al alcance de cualquiera, incluso sin conocimientos técnicos. Los usuarios pueden buscar, descargar y probar modelos en unos pocos clics, al tiempo que se benefician de un funcionamiento totalmente local, rápido y respetuoso con la privacidad. LM Studio también incorpora un servidor API compatible con OpenAI, lo que permite utilizar los modelos locales con cualquier aplicación o entorno de desarrollo.

LM Studio es adecuado tanto para ordenadores de consumo como para estaciones de trabajo más avanzadas. La aplicación explota tanto el procesador como la tarjeta gráfica para ofrecer una ejecución fluida con modelos que contienen miles de millones de parámetros. Gracias a este enfoque, convierte cualquier PC en un auténtico laboratorio personal de IA, capaz de responder a consultas complejas, escribir textos o procesar datos sin necesidad de acudir a la nube. LM Studio es una solución independiente para explorar el potencial de los modelos de inteligencia artificial.

Descubra mi tutorial sobre cómo instalar y utilizar LM Studio con DeepSeek R1 en Windows.

¿Dónde puedo descargar modelos locales de IA para Windows?

Para aprovechar al máximo el software de inteligencia artificial local, primero tienes que descargar el modelo que servirá de cerebro a tu asistente. Estos modelos, conocidos como LLM (Large Language Models), existen en varias versiones, en función de su tamaño, complejidad y recursos necesarios para ejecutarlos. Afortunadamente, las tres soluciones principales(Ollama, LM Studio y Jan AI) incluyen cada una su propia biblioteca de modelos.

- Ollama dispone de un catálogo oficial al que se puede acceder directamente desde el sitio web ollama.com/library. En él encontrará los modelos más populares, como Llama 3, Phi-3, Mistral y Gemma, listos para descargar y poner en marcha localmente.

- LM Studio también cuenta con una pestaña Descubrir, para que puedas buscar e instalar modelos de Hugging Face y otros repositorios de código abierto con un solo clic.

- Jan AI adopta un enfoque similar con su interfaz Hub, en la que los modelos recomendados se adaptan a la potencia de tu máquina para evitar ralentizaciones y errores de carga.

Además de las bibliotecas integradas, es posible descargar modelos de código abierto de plataformas como Hugging Face, GitHub y determinadas comunidades especializadas. Estos modelos se distribuyen en forma de archivos GGUF, un formato optimizado para la ejecución local.

Los mejores modelos de IA para PC de gama media

En un PC de gama media, es perfectamente posible ejecutar inteligencia artificial local, siempre que elijas el modelo adecuado. Contrariamente a la creencia popular, no necesitas una GPU cara o una máquina sobredimensionada para beneficiarte de la IA a diario. Modelos modernos como DeepSeek 8B o Mistral 7B han sido diseñados para funcionar en configuraciones asequibles, al tiempo que ofrecen una calidad de respuesta notable y rápida.

| Modelo | Talla | Destacados | Formato recomendado | Compatibilidad | Observaciones |

|---|---|---|---|---|---|

| DeepSeek 8B | 8 B | Excelente francés y capacidad de razonamiento | GGUF Q4_K_M | Ollama, LM Studio | Ideal para configuraciones pequeñas |

| Mistral 7B | 7 B | Versátil, respuesta natural | Q4_K_M | Ollama, LM Studio, Jan AI | Excelente equilibrio entre velocidad y calidad |

| Llama 3 8B | 8 B | Razonamiento avanzado, consistencia en respuestas largas | Q4_K_M | Ollama, LM Studio | Muy fiable |

| Phi-3 Mini (3.8B) | 3.8 B | Rápido, ligero, ideal para CPU | Q4_0 | Ollama, Jan AI | Para tareas sencillas |

Las plantillas cuantificadas en formato GGUF Q4_K_M o Q5_K_S son especialmente recomendables, ya que reducen la carga de memoria sin afectar a la calidad de las respuestas. Ya sea para escribir, resumir, codificar o simplemente charlar, estos modelos ofrecen una experiencia rápida comparable a la de las soluciones en la nube, pero totalmente local.