Con la popularización de modelos de IA de código abierto como Llama 3.2, Mistral, Phi, Gemma, DeepSeek y Qwen 2.5, cada vez más usuarios buscan ejecutarlos localmente para ganar autonomía y preservar sus datos personales. Sin embargo, instalar un modelo de IA en Windows 11 puede parecer complejo, especialmente para los principiantes. Esta guía ofrece un método simplificado para instalar y utilizar estos modelos de forma autónoma, sin necesidad de conocimientos avanzados de programación o aprendizaje automático.

DeepSeek R1: ¿Cómo instalo un modelo de IA localmente en Windows 11?

- ¿Cuál es la diferencia entre IA local y en la nube?

- Descargar e instalar LM Studio

- Descubra la interfaz de LM Studio y configure DeepSeek R1

La inteligencia artificial (IA) puede ejecutarse de dos formas principales: localmente (en tu propia máquina) o en la nube (a través de servidores remotos). Cada uno de estos enfoques tiene sus ventajas e inconvenientes, en función de los requisitos, los recursos de hardware y las limitaciones técnicas.

¿Cuál es la diferencia entre IA local y en la nube?

La IA local se ejecuta directamente en el ordenador del usuario. Una vez descargado el modelo, puede utilizarse sin conexión a Internet. Esta solución garantiza una confidencialidad total, ya que los datos permanecen en el dispositivo. También ofrece una capacidad de respuesta inmediata, sin la latencia asociada a un servidor remoto. Sin embargo, requiere un hardware adecuado(un procesador potente e, idealmente, una tarjeta gráfica de alto rendimiento). Algunos modelos, como Llama 3.2, Mistral, Phi, Gemma, DeepSeek o Qwen 2.5, pueden necesitar varios gigabytes de espacio de almacenamiento y recursos importantes para funcionar de forma óptima.

En cambio, la IA en la nube se basa en servidores remotos. Los usuarios envían sus consultas por Internet y reciben una respuesta generada a distancia. Este enfoque permite acceder a los modelos más avanzados sin limitaciones de hardware local. También es más sencillo de utilizar, ya que las actualizaciones y la optimización de los modelos las gestiona el proveedor. Sin embargo, requiere una conexión permanente y plantea problemas de confidencialidad, ya que las solicitudes pueden almacenarse o analizarse. Además, el coste puede llegar a ser importante en función de la intensidad de uso.

Descargar e instalar LM Studio

Empiece descargando LM Studio, una herramienta de código abierto que le permite ejecutar localmente modelos lingüísticos como Llama 3.2, Mistral, Phi, Gemma, DeepSeek y Qwen 2.5.

Visita el sitio web oficial de LM Studio y descarga la versión para Windows.

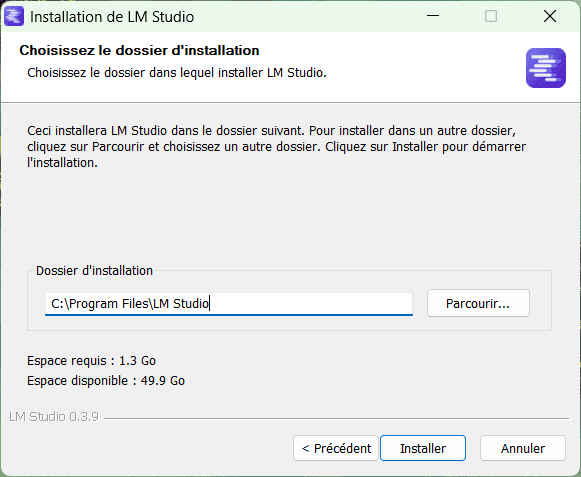

Ejecute el programa de instalación.

En el asistente de instalación, elija la carpeta de destino (C:Archivos de programa por defecto) y haga clic en Instalar.

Una vez finalizada la instalación, abre LM Studio.

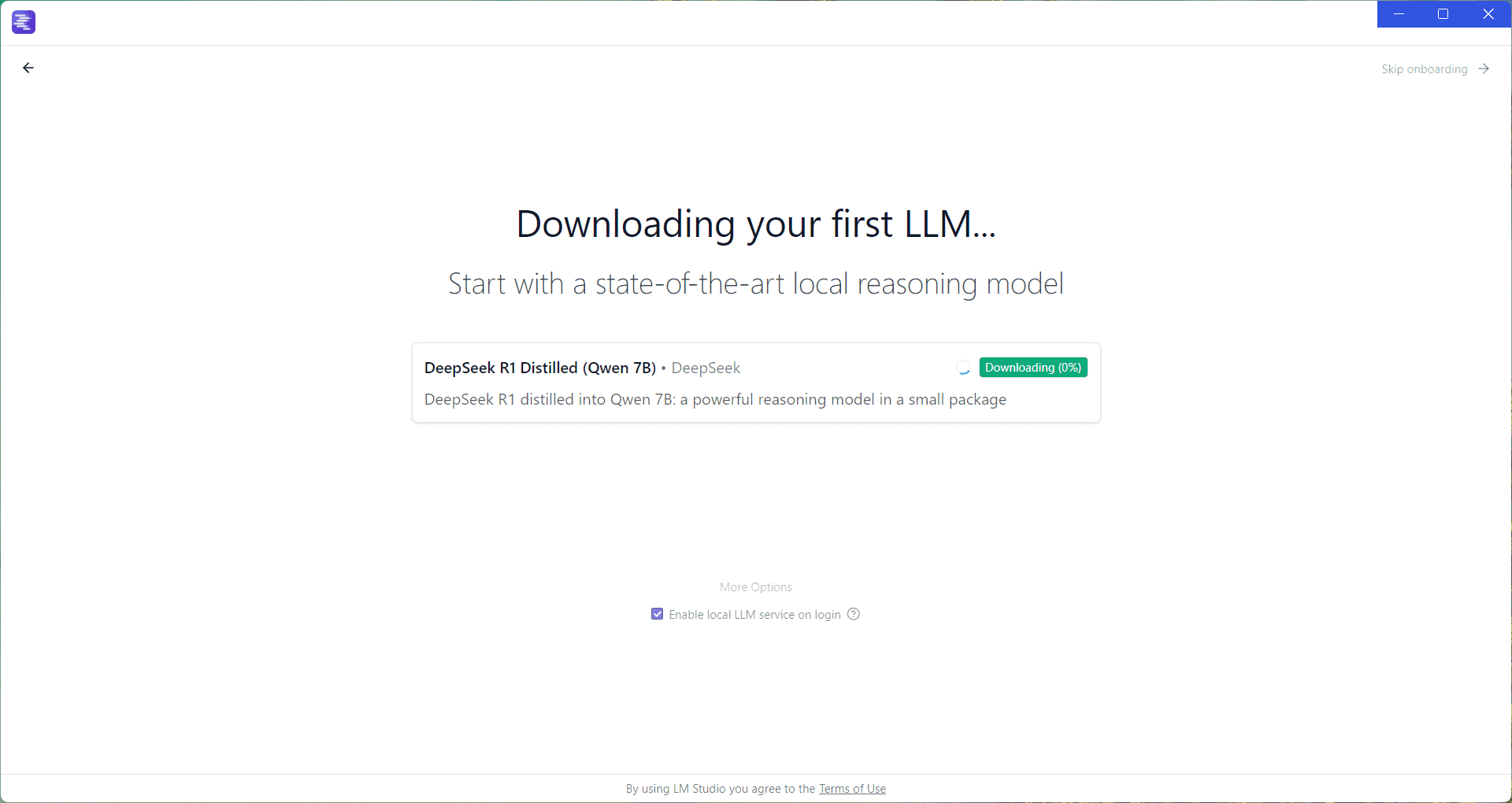

Cuando se inicia LM Studio por primera vez, aparece una interfaz de bienvenida. Esto le permite descargar un LLM (Large Language Model) y empezar a utilizarlo inmediatamente.

Por defecto, LM Studio sugiere descargar DeepSeek R1 Distilled (Qwen 7B), un modelo de alto rendimiento optimizado para uso local.

Haga clic en Descargar para iniciar la descarga del modelo.

Mientras se descarga, puede explorar la aplicación haciendo clic en Skip onboarding en la parte superior derecha de la pantalla.

Descubra la interfaz de LM Studio y configure DeepSeek R1

Ahora que ya tienes instalado tu primer modelo, tienes que cargarlo antes de poder utilizarlo.

Haga clic en Seleccionar un modelo para cargar y elija DeepSeek R1 Distilled (Qwen 7B) u otro modelo descargado.

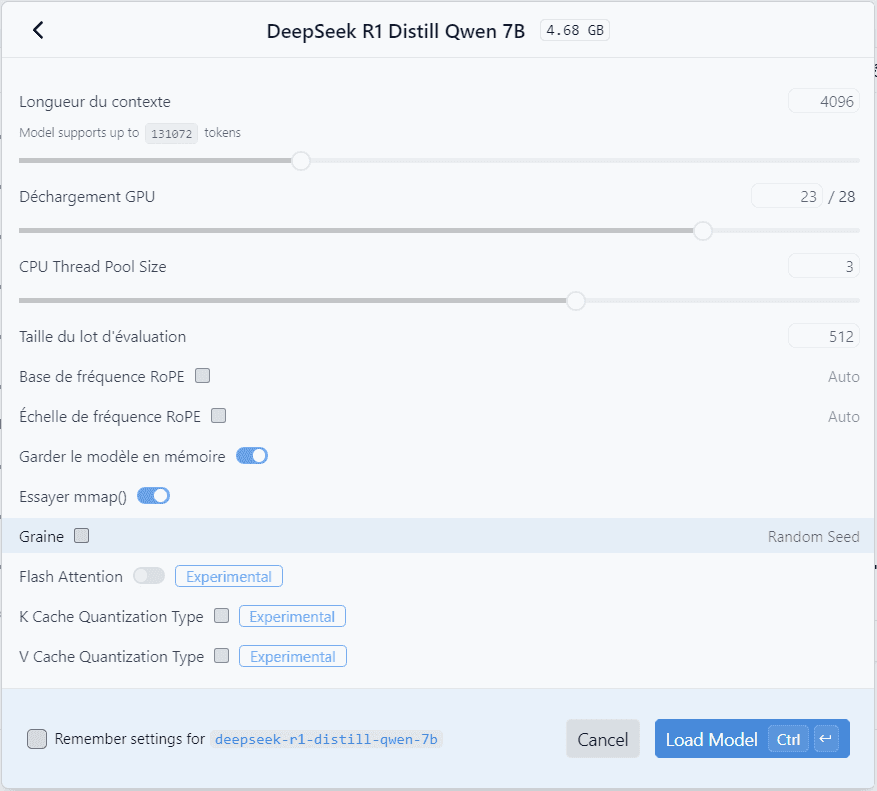

Se abre una ventana para configurar los parámetros del modelo:

- Cuantificación: ajusta la precisión del modelo para optimizar el rendimiento.

- Asignación de memoria: gestiona la RAM y la GPU utilizadas.

- Número de hilos: se ajusta en función del procesador para mejorar la velocidad de respuesta.

Si no está seguro de lo que hace, no toque nada y haga clic en Cargar modelo.

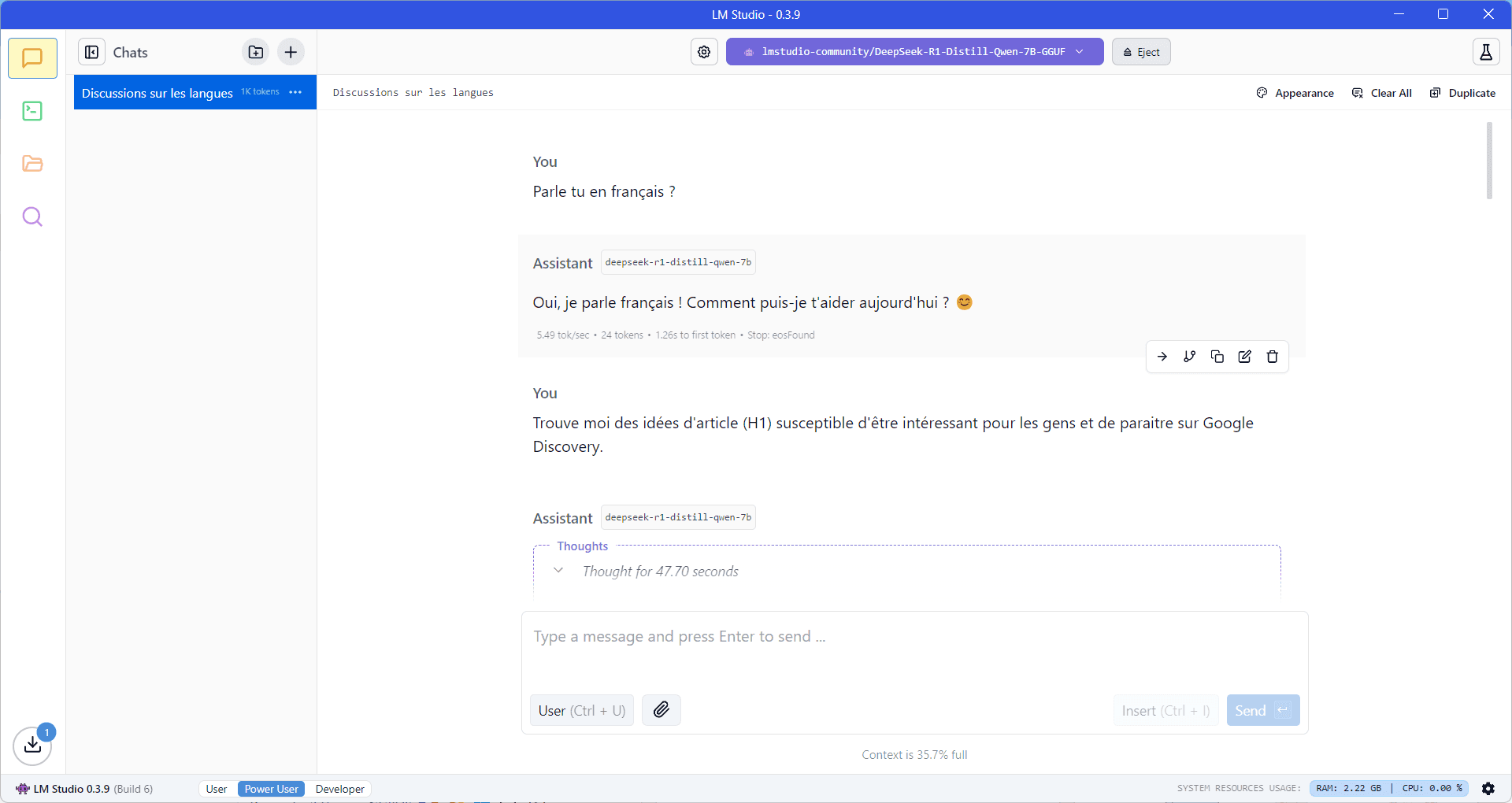

Una vez cargado, el modelo está listo para usar. Puedes hacerle preguntas directamente en la interfaz de chat, sin necesidad de conexión a Internet.

- Escriba su solicitud en el campo de entrada situado en la parte inferior de la pantalla.

- Las respuestas pueden generarse más o menos rápidamente en función de la potencia de su máquina.

- Un indicador en la parte inferior derecha muestra los recursos del sistema utilizados por LM Studio (CPU, RAM, GPU).

Gracias a LM Studio, ahora es fácil ejecutar un LLM localmente en Windows 11, sin depender de una conexión a Internet o de un servicio en la nube. En unos pocos pasos, puede instalar, configurar e interactuar con modelos como DeepSeek, Llama 3.2, Mistral o Qwen 2.5, garantizando al mismo tiempo la confidencialidad de sus datos.