La inteligencia artificial es una rama de la informática cuyo objetivo es crear sistemas capaces de realizar tareas que normalmente requieren inteligencia humana, como razonar, interpretar o tomar decisiones. Utiliza técnicas como el aprendizaje automático y el procesamiento del lenguaje natural. Al combinar matemáticas, informática y lingüística, la IA está revolucionando sectores enteros, desde la sanidad a las finanzas, sin olvidar la creación digital. Pero, ¿qué hay realmente detrás de este nuevo concepto que se ha convertido en imprescindible?

¿Qué es la inteligencia artificial (IA)?

- ¿Cómo puede un ordenador entenderme y responderme?

- 1950: Una prueba experimental y el descubrimiento de la primera inteligencia artificial

- 2011: Google Brain para la búsqueda en línea

- 2022: ChatGPT, inteligencia artificial conversacional de OpenAI

- Transformador Generativo Preentrenado: ¿Cómo funciona la IA?

¿Cómo puede un ordenador entenderme y responderme?

Durante décadas, la idea de un ordenador capaz de hablar y entender nuestro idioma parecía cosa de ciencia ficción. Hoy, sin embargo, esta visión se ha hecho realidad gracias a los espectaculares avances de la informática y el procesamiento del lenguaje natural (PLN).

Cuando hablamos de lenguaje natural, nos referimos a la forma en que nos comunicamos los seres humanos: frases llenas de matices, ambigüedad, emoción y a veces incluso contradicción. Para que un ordenador comprenda este complejo lenguaje, no basta con programar un diccionario. Tiene que aprender a pensar como nosotros, o al menos a reconocer las estructuras gramaticales, los contextos culturales y las intenciones que hay detrás de cada palabra.

Modelos recientes como Gemini o ChatGPT utilizan miles de millones de datos textuales para aprender a responder de forma natural y contextual.

Por supuesto, la comprensión del lenguaje humano por parte de los ordenadores no es perfecta. Los matices culturales, las expresiones idiomáticas e incluso el humor siguen siendo obstáculos.

1950: Una prueba experimental y el descubrimiento de la primera inteligencia artificial

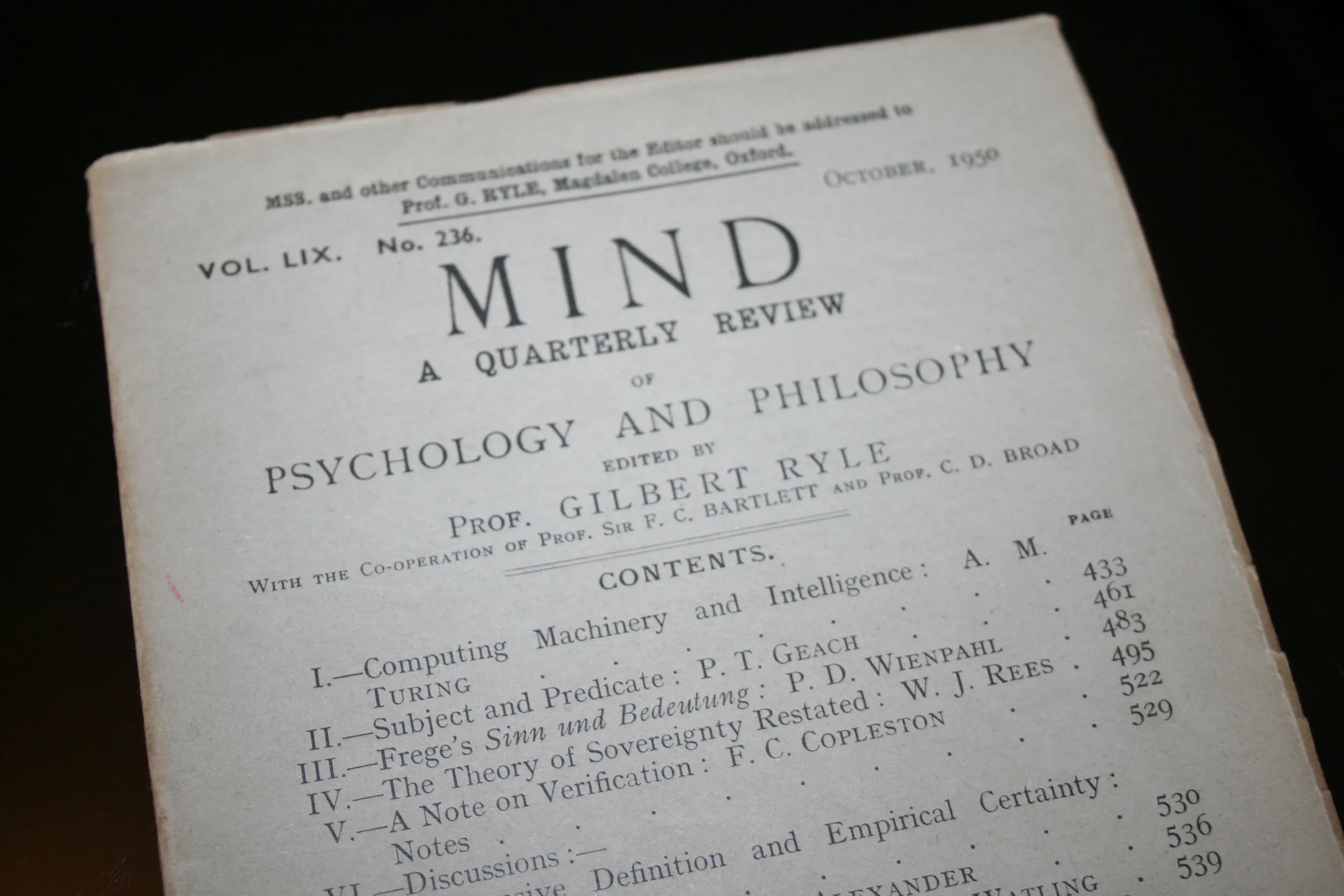

La historia de los ordenadores capaces de comprender el lenguaje humano natural se remonta a los años 50, cuando el matemático británico Alan Turing publicó un artículo titulado Computing Machinery and Intelligence (Máquinas de computación e inteligencia), en el que proponía la famosa «prueba de Turing». Esta prueba pretende determinar si una máquina puede mostrar un comportamiento inteligente indistinguible del de un ser humano evaluando su capacidad para entablar una conversación en lenguaje natural.

Esta idea inspiró a varios investigadores, entre ellos Joseph Weizenbaum, que desarrolló el programa ELIZA en el MIT en 1966. ELIZA simula una conversación adoptando el papel de un terapeuta rogeriano, que responde a los usuarios reformulando sus afirmaciones en forma de preguntas. Aunque se basa en simples reglas de correspondencia de patrones, ELIZA demostró la viabilidad de la interacción hombre-máquina en lenguaje natural, suscitando tanto fascinación como debate sobre los límites de la comprensión real por parte de las máquinas.

2011: Google Brain para la búsqueda en línea

En 2011, Google puso en marcha el proyecto Google Brain, una ambiciosa iniciativa para explorar el potencial de la inteligencia artificial (IA) y las redes neuronales profundas. El proyecto, que comenzó como una colaboración entre Google e investigadores de Stanford, evolucionó rápidamente hasta convertirse en un pilar central de la innovación tecnológica en Google.

Desde el principio, Google Brain ha tenido un impacto significativo en uno de los productos estrella de la empresa: su motor de búsqueda.

El principal objetivo de Google Brain era ampliar los límites de la tecnología combinando el aprendizaje profundo con la enorme potencia de cálculo de Google. La idea era utilizar algoritmos inspirados en el cerebro humano para analizar, comprender e interpretar datos a una escala sin precedentes.

Al aplicar esta tecnología al motor de búsqueda, Google pretendía mejorar la relevancia de los resultados y comprender las intenciones de los usuarios, incluso cuando sus consultas eran ambiguas o estaban mal formuladas.

2022: ChatGPT, inteligencia artificial conversacional de OpenAI

ChatGPT, desarrollado por OpenAI, es un modelo avanzado de inteligencia artificial diseñado para interactuar con los usuarios a través de conversaciones naturales. Basado en la tecnología GPT (Generative Pre-trained Transformer), es capaz de comprender y generar textos en numerosos idiomas y sobre multitud de temas.

ChatGPT destaca en diversos ámbitos: redacción de artículos, creación de contenidos de marketing, prestación de asistencia técnica, explicación de conceptos complejos e incluso como asistente de código informático. Su capacidad para adaptarse al tono y al estilo requeridos lo convierte en una herramienta especialmente útil para profesionales, estudiantes y creadores de contenidos.

El modelo se basa en el aprendizaje profundo, entrenado con enormes cantidades de datos textuales. Gracias a sus mecanismos de preentrenamiento y ajuste, puede proporcionar respuestas precisas, coherentes y a menudo contextualmente relevantes. Esto le permite simular una comprensión casi humana de los diálogos.

ChatGPT nació de la amplia investigación de OpenAI sobre modelos lingüísticos. OpenAI, fundada en 2015 por gente como Elon Musk y Sam Altman, tenía la misión de democratizar el acceso a la inteligencia artificial, garantizando al mismo tiempo su desarrollo ético.

Transformador Generativo Preentrenado: ¿Cómo funciona la IA?

Los modelos Generative Pre-trained Transformer (GPT) se basan en la arquitectura Transformer introducida por primera vez en el artículo«Attention Is All You Need» (Vaswani et al., 2017). Los GPT se consideran entonces redes neuronales profundas capaces de analizar y generar lenguaje natural a gran escala. Se denominan preentrenadas porque primero se exponen a enormes cantidades de texto (esta es la fase de preentrenamiento) y luego se pueden especializar o ajustar para diversas tareas (esta es la fase de ajuste fino).

Un poco de historia: ¿de dónde surgió la idea de Transformer?

Retrocedamos unos años. Antes de Transformers, el procesamiento del lenguaje natural se basaba en métodos más tradicionales, como las redes recurrentes (RNN, LSTM) o los enfoques estadísticos. Estas técnicas funcionaban, pero tenían dificultades para comprender el contexto de las frases largas. Cuanto más larga era la frase, más difícil le resultaba a la IA seguir el hilo. El resultado era cierta dificultad para procesar textos complejos.

En lugar de procesar las palabras una a una por orden, el Transformer utiliza un mecanismo deatención que le permite centrarse en todas las partes de una frase simultáneamente. Esto facilita enormemente la comprensión y manipulación de largas secuencias de texto, sin que la máquina se pierda por el camino. Este avance ha cambiado las reglas del juego, allanando el camino para modelos más potentes y versátiles.

La parte más profunda: tragar gigatoneladas de texto

Cuando hablamos de la fase de entrenamiento (o preentrenamiento) de una GPT, estamos describiendo un proceso en el que la IA examinará miles de millones de palabras. Libros digitales, artículos de blogs, sitios web… en definitiva, cualquier cosa accesible en formato de texto. ¿El objetivo? Aprender las reglas del lenguaje, desde la gramática básica hasta las sutilezas estilísticas, sin tener que ponerle la más mínima etiqueta de «correcto/incorrecto». Se llama autosupervisión.

El principio es sencillo: en cada etapa, GPT intentará adivinar la siguiente palabra de una frase, basándose en el contexto anterior. Se puede considerar como un gigantesco juego de adivinanzas, en el que el modelo perfecciona sus estadísticas mediante predicciones sucesivas. Poco a poco, perfecciona su conocimiento de la lengua, comprende la correlación entre las palabras y, en el proceso, reúne una gran cantidad de información sobre el mundo (que a veces escupe sin filtrar, por cierto).

Puesta a punto: especialización

Una vez que GPT ha digerido inmensas cantidades de texto, ya es capaz de producir contenidos coherentes. Pero no nos detenemos ahí. Hay otra fase de «puesta a punto» en la que especializamos el modelo. Por ejemplo, si queremos un chatbot de asistencia médica, lo afinaremos con datos sanitarios verificados, para que responda con precisión y cautela.

Este pulido también puede hacerse mediante el Aprendizaje por Refuerzo con Retroalimentación Humana (RLHF), que consiste en mostrar posibles respuestas a evaluadores humanos. Los evaluadores marcan los resultados y la IA aprende a ajustarse lo más posible a las expectativas humanas.