Avec la popularisation des modèles d’intelligence artificielle open source comme Llama 3.2, Mistral, Phi, Gemma, DeepSeek et Qwen 2.5, de plus en plus d’utilisateurs cherchent à les exécuter localement pour gagner en autonomie et préserver leurs données personnelles. Pourtant, l’installation d’un modèle d’IA sur Windows 11 peut sembler complexe, surtout pour un débutant. Ce guide vous propose une méthode simplifiée pour installer et utiliser ces modèles en toute autonomie, sans nécessiter de compétences avancées en programmation ou en machine learning.

LM Studio : Comment installer localement un modèle d’IA sur Windows 11 ?

- Quelle différence entre IA local et cloud ?

- Télécharger et installer LM Studio

- Découvrez l’interface de LM Studio et configurer DeepSeek R1

L’exécution d’une intelligence artificielle (IA) peut se faire de deux manières principales : en local (sur votre propre machine) ou dans le cloud (via des serveurs distants). Chacune de ces approches présente des avantages et des inconvénients en fonction des besoins, des ressources matérielles et des contraintes techniques.

Quelle différence entre IA local et cloud ?

L’IA locale fonctionne directement sur l’ordinateur de l’utilisateur. Une fois le modèle téléchargé, il peut être utilisé sans connexion Internet. Cette solution garantit une confidentialité totale puisque les données restent sur l’appareil. Elle offre également une réactivité immédiate, sans latence liée à un serveur distant. Toutefois, elle nécessite un matériel adapté (processeur puissant et idéalement une carte graphique performante). Certains modèles comme Llama 3.2, Mistral, Phi, Gemma, DeepSeek ou Qwen 2.5 peuvent demander plusieurs gigaoctets d’espace de stockage et des ressources importantes pour fonctionner de manière optimale.

À l’inverse, l’IA en cloud repose sur des serveurs distants. L’utilisateur envoie ses requêtes via Internet et reçoit une réponse générée à distance. Cette approche permet d’accéder aux modèles les plus avancés sans contrainte matérielle locale. Elle est aussi plus simple à utiliser car les mises à jour et l’optimisation des modèles sont gérées par le fournisseur. Cependant, elle impose une connexion permanente et soulève des questions de confidentialité, les requêtes pouvant être stockées ou analysées. De plus, son coût peut devenir significatif selon l’intensité d’utilisation.

Mais au fait, c’est quoi l’intelligence artificielle ?

Télécharger et installer LM Studio

Commencez par télécharger LM Studio, un outil open source qui permet d’exécuter localement des modèles de langage comme Llama 3.2, Mistral, Phi, Gemma, DeepSeek ou Qwen 2.5.

Rendez-vous sur le site officiel de LM Studio et téléchargez la version adaptée à Windows.

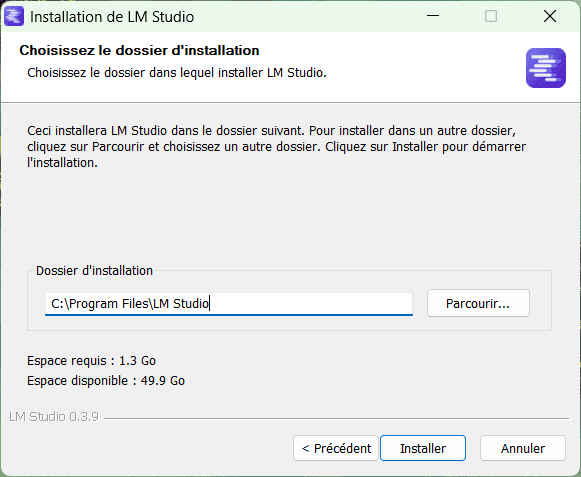

Lancez le programme d’installation.

Dans l’assistant d’installation, choisissez le dossier de destination (C:\Program Files\LM Studio par défaut) et cliquez sur Installer.

Une fois l’installation terminée, ouvrez LM Studio.

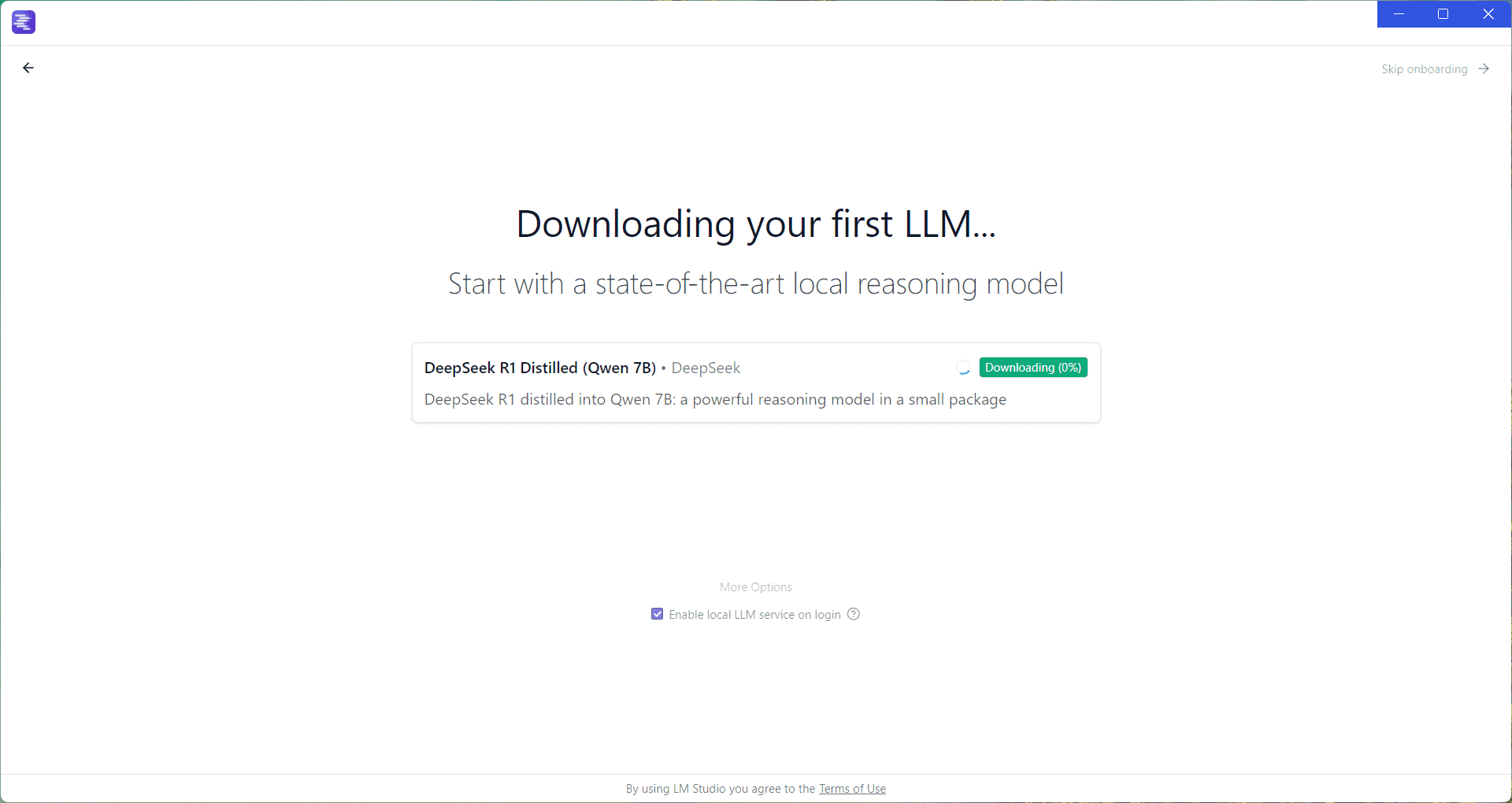

Lors du premier lancement de LM Studio, une interface d’accueil apparaît. Cette étape permet de télécharger un LLM (Large Language Model) pour commencer à l’utiliser immédiatement.

Par défaut, LM Studio propose de télécharger DeepSeek R1 Distilled (Qwen 7B), un modèle performant et optimisé pour un usage local.

Cliquez sur Download pour lancer le téléchargement du modèle.

Pendant le téléchargement, il est possible d’explorer l’application en cliquant sur Skip onboarding en haut à droite de l’écran.

Découvrez l’interface de LM Studio et configurer DeepSeek R1

Maintenant que votre premier modèle est installé, vous devez le charger avant de pouvoir l’utiliser.

Cliquez sur Select a model to load et choisissez DeepSeek R1 Distilled (Qwen 7B) ou un autre modèle téléchargé.

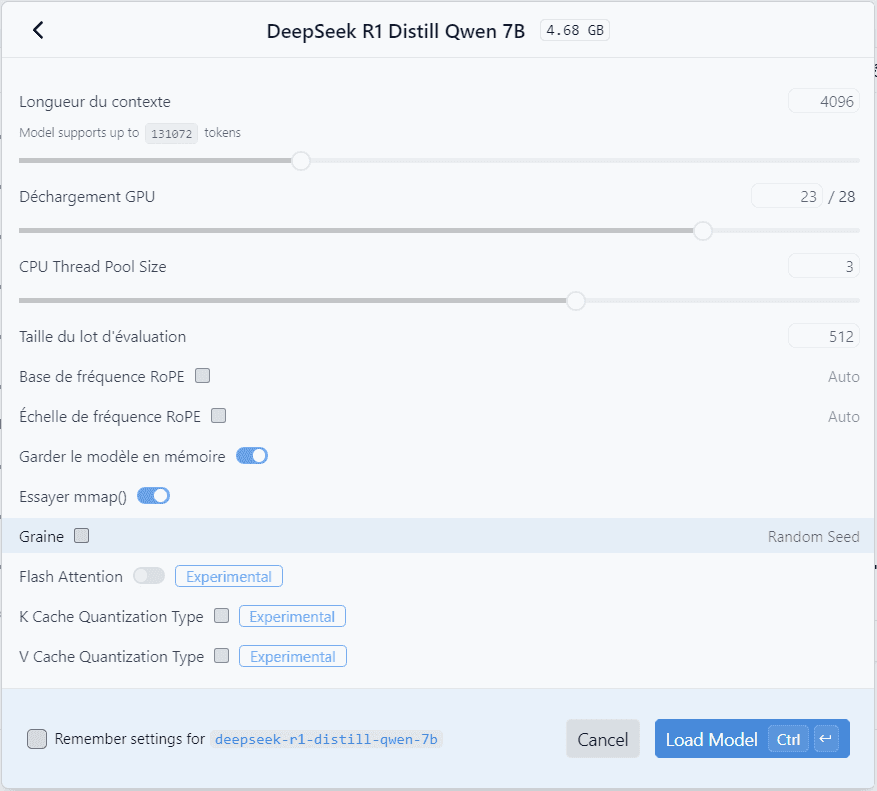

Une fenêtre s’ouvre pour configurer les paramètres du modèle :

- Quantisation : ajuste la précision du modèle pour optimiser les performances.

- Allocation de mémoire : permet de gérer la RAM et le GPU utilisés.

- Nombre de threads : à ajuster en fonction du processeur pour améliorer la rapidité des réponses.

Si vous n’êtes pas sûr de ce que vous faites, ne touchez à rien et cliquez sur Load Model.

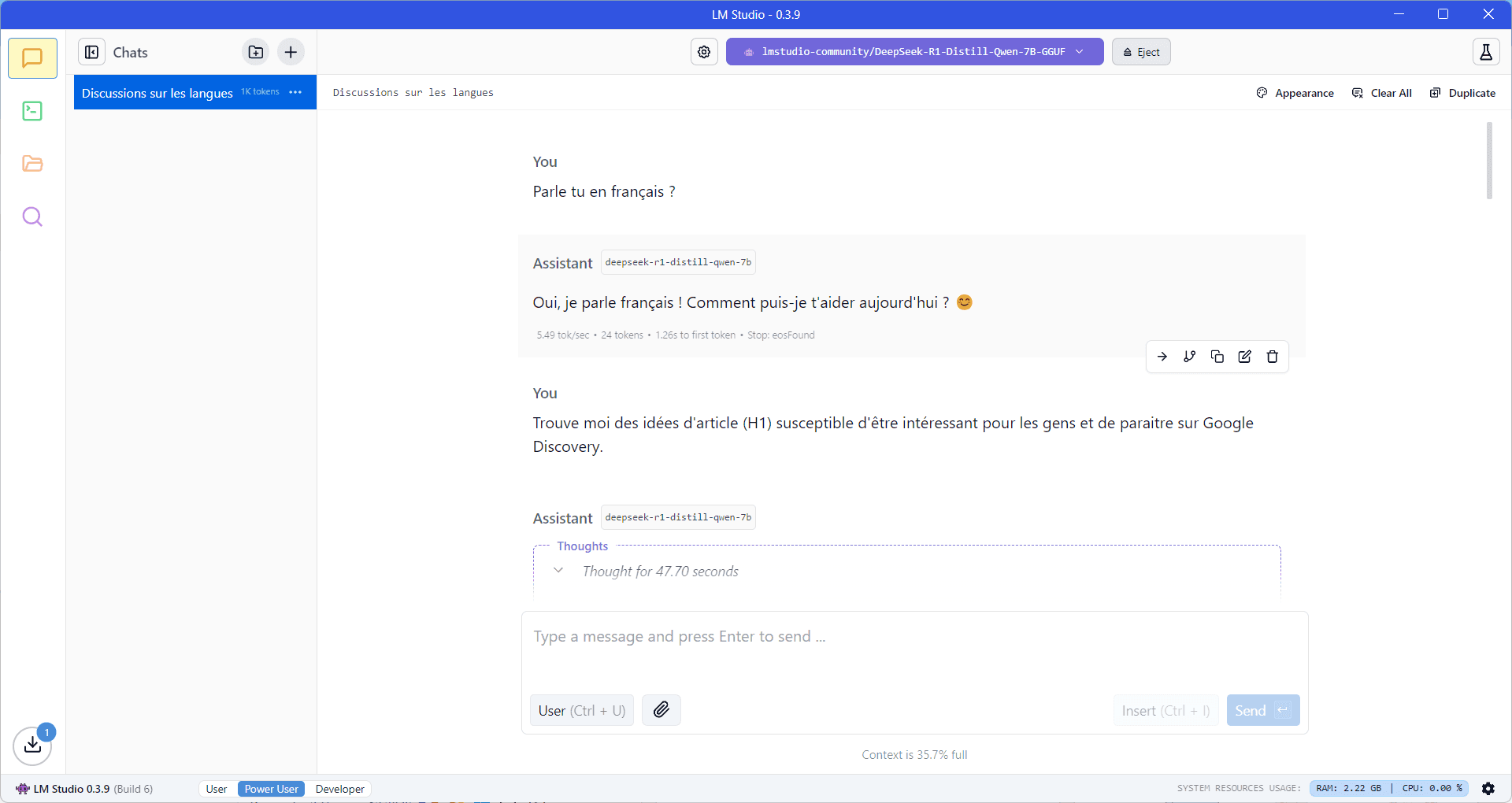

Une fois chargé, le modèle est prêt à être utilisé. Vous pouvez lui poser des questions directement dans l’interface de chat, sans connexion Internet.

- Tapez votre requête dans le champ de saisie en bas de l’écran.

- Les réponses peuvent être générées plus ou moins rapidement selon la puissance de votre machine.

- Un indicateur en bas à droite affiche les ressources système utilisées par LM Studio (CPU, RAM, GPU).

Grâce à LM Studio, il est désormais simple d’exécuter un LLM en local sur Windows 11, sans dépendre d’une connexion Internet ni d’un service cloud. En quelques étapes, vous pouvez installer, configurer et interagir avec des modèles comme DeepSeek, Llama 3.2, Mistral ou Qwen 2.5, tout en garantissant la confidentialité de vos données.