L’intelligence artificielle est une branche de l’informatique qui vise à créer des systèmes capables d’exécuter des tâches nécessitant normalement l’intelligence humaine comme le raisonnement, l’interprétation ou la prise de décision. Grâce à des techniques telles que l’apprentissage automatique et le traitement du langage naturel. En combinant mathématiques, informatique et languistique, l’IA révolutionne des secteurs entiers, de la santé à la finance, en passant par la création digitale. Mais que se cache-t-il vraiment derrière ce nouveau concept devenu incontournable ?

Qu’est-ce que l’intelligence artificielle (IA) ?

- Comment un ordinateur peut-il me comprendre et me répondre ?

- 1950 : Un test expérimental et la découverte de la première IA

- 2011 : Google Brain au service de la recherche en ligne

- 2022 : ChatGPT L’intelligence artificielle conversationnelle

- Generative Pre-trained Transformer : Comment fonctionne l’IA ?

Comment un ordinateur peut-il me comprendre et me répondre ?

Depuis des décennies, l’idée d’un ordinateur capable de parler et de comprendre notre langage semblait relever de la science-fiction. Pourtant, aujourd’hui, cette vision est devenue une réalité grâce aux avancées spectaculaires en informatique et en traitement du langage naturel (NLP).

Lorsque nous parlons de langage naturel, il s’agit de la manière dont nous, humains, communiquons : des phrases nuancées, pleines d’ambiguïtés, d’émotions et parfois même de contradictions. Pour qu’un ordinateur puisse saisir ce langage complexe, il ne suffit pas simplement programmer un dictionnaire. Il faut qu’il apprenne à penser comme nous ou du moins à reconnaître les structures grammaticales, les contextes culturels et les intentions derrière chaque mot.

Les modèles récents comme Gemini ou ChatGPT utilisent des milliards de données textuelles pour apprendre à répondre de manière naturelle et contextuelle.

Bien sûr, la compréhension du langage humain par les ordinateurs n’est pas parfaite. Les nuances culturelles, les expressions idiomatiques, voire l’humour, restent des obstacles.

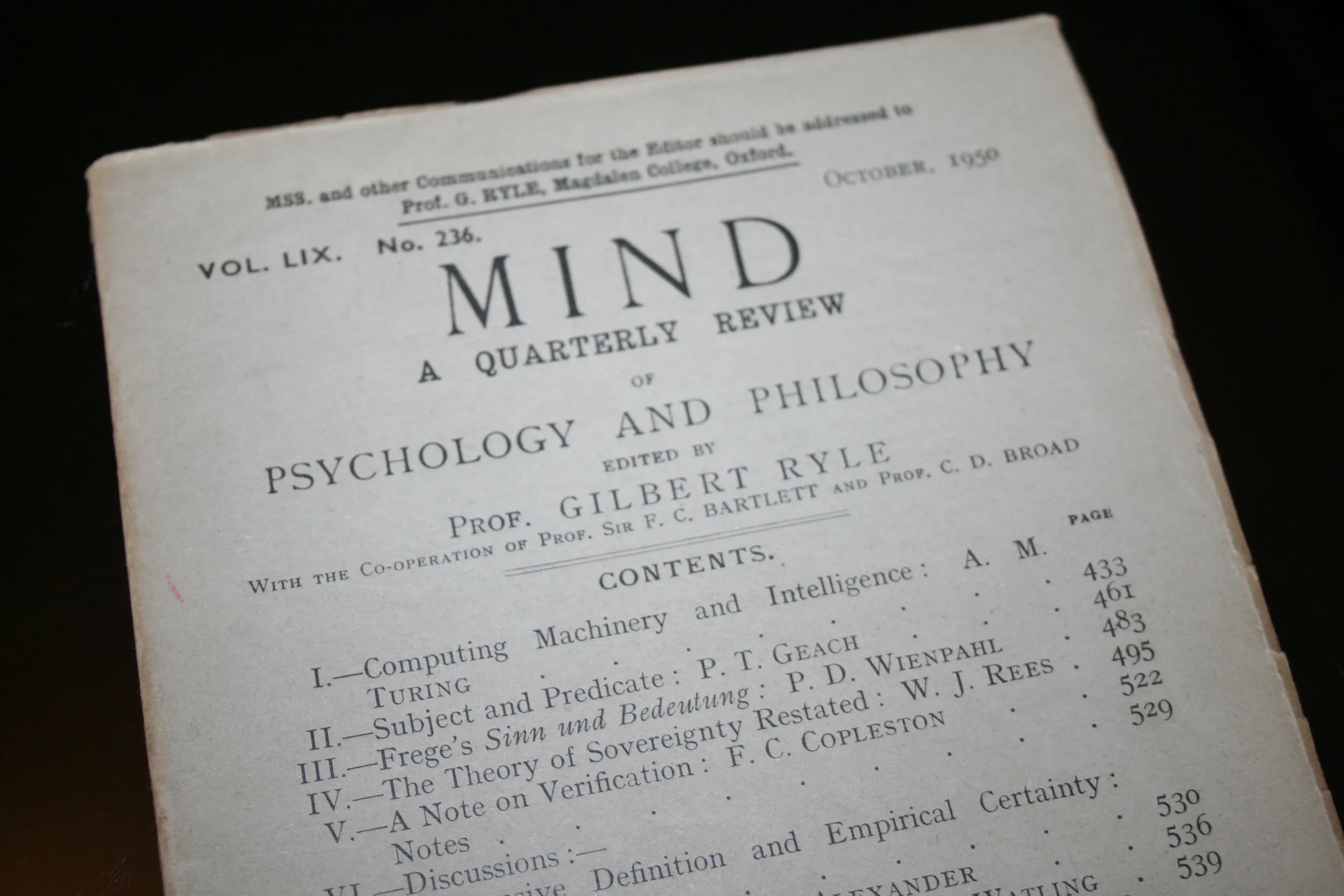

1950 : Un test expérimental et la découverte de la première IA

L’histoire des ordinateurs capables de comprendre le langage naturel humain remonte aux années 1950, lorsque le mathématicien britannique Alan Turing publie un article intitulé Computing Machinery and Intelligence, où il propose le célèbre « test de Turing ». Ce test vise à déterminer si une machine peut exhiber un comportement intelligent indiscernable de celui d’un humain en évaluant sa capacité à engager une conversation en langage naturel.

Cette idée inspire de nombreux chercheurs dont Joseph Weizenbaum, qui développe en 1966 le programme ELIZA au MIT. ELIZA simule une conversation en adoptant le rôle d’un thérapeute rogérien, répondant aux utilisateurs en reformulant leurs déclarations sous forme de questions. Bien que basé sur des règles simples de correspondance de motifs, ELIZA démontre la faisabilité d’interactions homme-machine en langage naturel, suscitant à la fois fascination et débats sur les limites de la compréhension réelle par les machines.

2011 : Google Brain au service de la recherche en ligne

En 2011, Google a lancé le projet Google Brain, une initiative ambitieuse visant à explorer le potentiel de l’intelligence artificielle (IA) et des réseaux neuronaux profonds. Ce projet, qui a débuté comme une collaboration entre Google et des chercheurs de Stanford a rapidement évolué pour devenir un pilier central de l’innovation technologique chez Google.

Dès ses débuts, Google Brain a eu un impact significatif sur l’un des produits phares de l’entreprise : son moteur de recherche.

L’objectif principal de Google Brain était de repousser les limites de la technologie en combinant l’apprentissage profond (deep learning) avec la puissance de calcul massive de Google. L’idée était d’utiliser des algorithmes inspirés du cerveau humain pour analyser, comprendre et interpréter les données à une échelle jamais atteinte.

En appliquant cette technologie au moteur de recherche, Google visait à améliorer la pertinence des résultats et à comprendre les intentions des utilisateurs, même lorsque leurs requêtes étaient ambiguës ou mal formulées.

2022 : ChatGPT L’intelligence artificielle conversationnelle

ChatGPT, développé par OpenAI est un modèle avancé d’intelligence artificielle générative conçu pour interagir avec les utilisateurs via des conversations naturelles. Basé sur la technologie GPT (Generative Pre-trained Transformer), il est capable de comprendre et de générer du texte dans de nombreuses langues et sur une multitude de sujets.

ChatGPT excelle dans divers domaines : rédaction d’articles, création de contenu marketing, assistance technique, explication de concepts complexes, et même comme assistant pour le code informatique. Sa capacité à s’adapter au ton et au style requis en fait un outil particulièrement utile pour les professionnels, les étudiants et les créateurs de contenu.

Le modèle repose sur un apprentissage profond, entraîné sur d’énormes quantités de données textuelles. Grâce à son mécanisme de pré-entraînement et de fine-tuning, il peut fournir des réponses précises, cohérentes et souvent contextuellement pertinentes. Cela lui permet de simuler une compréhension quasi-humaine des dialogues.

ChatGPT est né des recherches approfondies d’OpenAI sur les modèles de langage. OpenAI, fondée en 2015 par des personnalités comme Elon Musk et Sam Altman avait pour mission de démocratiser l’accès à l’intelligence artificielle tout en veillant à son développement éthique.

Generative Pre-trained Transformer : Comment fonctionne l’IA ?

Les modèles de type Generative Pre-trained Transformer (GPT) sont basés sur l’architecture Transformer introduite initialement dans l’article « Attention Is All You Need » (Vaswani et al., 2017). Les GPT sont alors considérés comme des réseaux de neurones profonds capables d’analyser et de générer du langage naturel à grande échelle. On les appelle pré-entraînés parce qu’ils sont d’abord exposés à d’énormes quantités de texte (c’est la phase de pré-entraînement) puis ils peuvent être spécialisés ou ajustés pour diverses tâches (c’est la phase de fine-tuning).

Un peu de contexte : d’où vient l’idée du Transformer ?

Revenons quelques années en arrière. Avant les Transformers, le traitement du langage naturel s’appuyait sur des méthodes plus classiques comme les réseaux récurrents (RNN, LSTM) ou les approches statistiques. Ces techniques fonctionnaient, mais avaient du mal dès qu’il s’agissait de comprendre le contexte de longues phrases. Plus la phrase était longue, plus l’IA avait du mal à garder le fil. Résultat, une certaine difficulté à traiter des textes complexes.

Au lieu de traiter les mots un par un dans l’ordre, le Transformer utilise un mécanisme d’attention qui lui permet de se focaliser sur toutes les parties d’une phrase simultanément. Il devient ainsi beaucoup plus facile de comprendre et de manipuler de longues séquences de texte, sans que la machine se perde en route. Cette avancée a changé la donne, en ouvrant la voie à des modèles plus puissants et plus versatiles.

Le grand bain : ingurgiter des giga-tonnes de texte

Quand on parle de phase d’entraînement (ou pré-entraînement) pour un GPT, on décrit un processus où l’IA va passer au crible des milliards de mots. Livres numériques, articles de blogs, sites web… Bref, tout ce qui est accessible en format texte. Le but ? Apprendre les règles de la langue, de la grammaire basique aux subtilités stylistiques sans qu’on ait à lui donner la moindre étiquette « correct / incorrect ». C’est ce qu’on appelle l’auto-supervision.

Le principe est simple : à chaque étape, GPT va essayer de deviner le mot suivant dans une phrase, juste en se basant sur le contexte précédent. On peut voir ça comme un gigantesque jeu de devinette, où le modèle affine ses statistiques à force de prédictions successives. Petit à petit, il perfectionne sa connaissance de la langue, comprend la corrélation entre les mots et, au passage, emmagasine un tas d’infos sur le monde (qu’il recrachera parfois sans filtre, d’ailleurs !).

Le fine-tuning : la spécialisation

Une fois que GPT a digéré d’immenses quantités de texte, il est déjà capable de produire du contenu cohérent. Mais on ne s’arrête pas là. Il existe une autre étape de « fine-tuning » durant laquelle on va spécialiser le modèle. Par exemple, si on veut un chatbot d’assistance médicale, on va le fine-tuner avec des données de santé vérifiées, afin qu’il réponde avec exactitude et prudence.

Ce polissage peut aussi se faire par le biais du « Reinforcement Learning with Human Feedback (RLHF) », qui consiste à montrer des réponses potentielles à des évaluateurs humains. Ces derniers notent les résultats et l’IA apprend à coller au plus près des attentes humaines.