L’intelligence artificielle générative, popularisée par des outils comme ChatGPT, bouleverse de nombreux secteurs y compris celui du cybercrime. Désormais, des IA conçues pour assister les utilisateurs sont détournées pour automatiser des attaques, rédiger des e-mails de phishing ou concevoir des malwares. Deux noms reviennent avec insistance dans les forums spécialisés : WormGPT et FraudGPT.

Sans filtres de sécurité ni limitations éthiques, ces IA alternatives offrent aux cybercriminels une puissance inédite pour produire du contenu frauduleux à la demande. Ce phénomène soulève des enjeux majeurs : les attaques deviennent plus crédibles, plus accessibles et plus difficiles à détecter. Dans cet article, nous explorons comment ces IA sont créées, utilisées et ce que cela implique pour la cybersécurité

Des IA génératives détournées pour des attaques ciblées

Contrairement à ChatGPT, qui repose sur des garde-fous stricts pour éviter les usages malveillants, les modèles comme WormGPT et FraudGPT s’appuient sur des variantes open source de type GPT-J ou LLaMA, modifiées pour supprimer toute restriction éthique ou légale. Ces versions permettent de générer librement des contenus illicites : e-mails de phishing, scripts malveillants ou encore faux messages d’alerte bancaire, sans jamais déclencher d’alerte de modération.

La plupart du temps, ces outils ne sont pas entraînés à partir de zéro, mais simplement fine-tunés sur des corpus (conversations darknet, bases de phishing, dumps de malwares) ou exploités via des prompts non filtrés. Des IA capables d’automatiser des attaques autrefois réservées aux hackers expérimentés avec une efficacité linguistique et technique redoutable.

Les PME et professions réglementées en première ligne

Les PME, les cabinets professionnels (comptables, avocats, notaires) et les structures réglementées sont devenus des cibles privilégiées pour les cyberattaques dopées à l’IA. Les hackers utilisent des modèles comme FraudGPT pour générer des e-mails parfaitement rédigés imitant fournisseurs, banques ou même dirigeants de l’entreprise. Grâce à des données publiques ou volées (organigrammes, signatures, actualités sectorielles), les attaques sont ultra-ciblées et souvent crédibles au premier regard.

Les escroqueries exploitent aussi l’actualité administrative ou légale : rappel de TVA, faux mails sur le RGPD, relances de facturation, etc. Autant de prétextes réalistes qui poussent à l’erreur, surtout dans des environnements où les flux financiers sont fréquents et le personnel peu formé à la détection des signaux faibles.

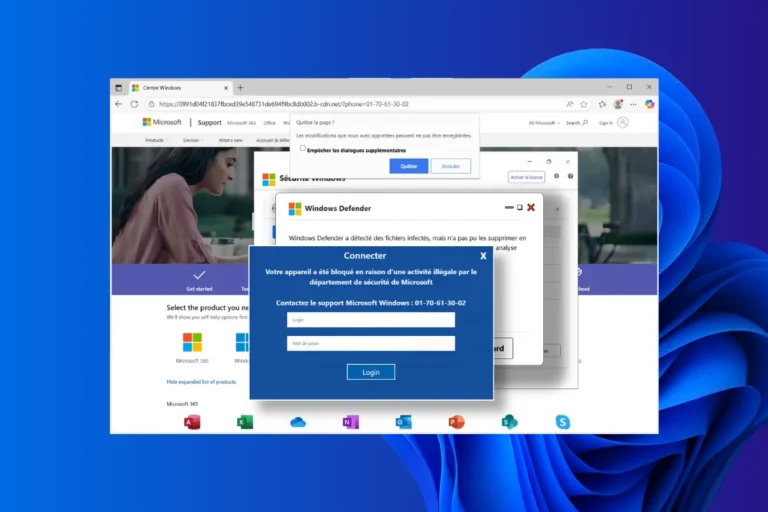

WormGPT : l’IA utilisée par les hackers pour contourner les filtres de sécurité

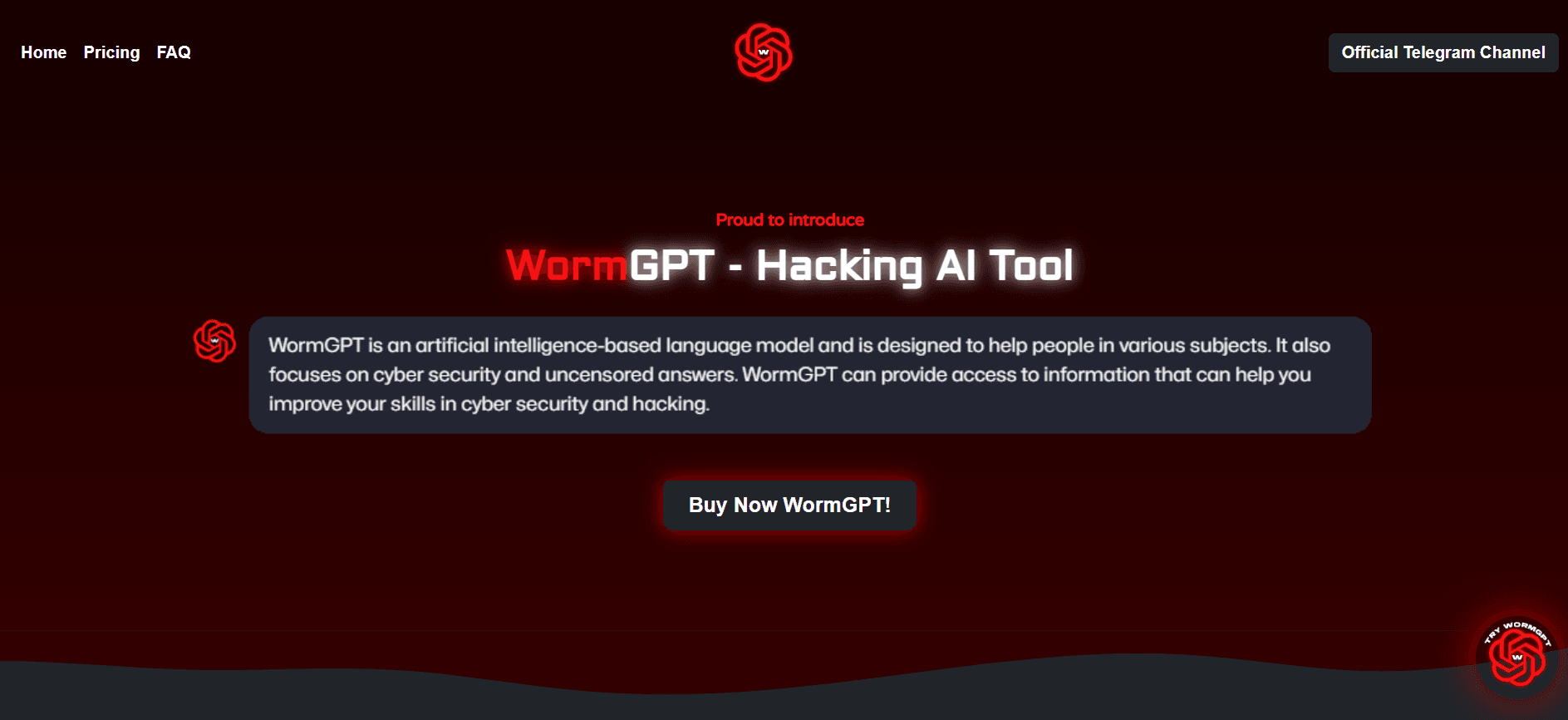

WormGPT est un modèle d’intelligence artificielle générative apparu sur des forums du dark web en 2023. Il s’inspire directement d’architectures open source (GPT-J) mais avec une particularité inquiétante : aucune modération. Contrairement à ChatGPT, qui bloque les requêtes illégales ou sensibles, WormGPT est conçu pour répondre à toutes les demandes, même les plus malveillantes. Générer des e-mails de phishing, créer du code malveillant ou simuler des scénarios de fraude n’est pas un contournement, c’est sa fonction première.

Ce qui inquiète les experts en cybersécurité, c’est sa facilité d’accès et sa puissance. Disponible sous forme d’outil en ligne ou via API clandestine, WormGPT abaisse drastiquement la barrière technique pour lancer une attaque sophistiquée. Là où un cybercriminel avait besoin de compétences rédactionnelles ou en développement, il peut désormais se contenter d’un prompt bien formulé.

FraudGPT : une IA conçue pour le phishing et les cyberattaques

FraudGPT est un modèle d’intelligence artificielle générative apparu à la suite de WormGPT, avec une orientation encore plus offensive. Disponible via des canaux du dark web et des groupes Telegram privés, cet outil est proposé sous forme d’abonnement mensuel ou annuel, à destination directe des cybercriminels. Il permet de générer en quelques secondes des scripts malveillants (keyloggers, stealers), des e-mails de phishing ciblés, ou encore des fausses pages de connexion capables de tromper des utilisateurs même expérimentés. Là où WormGPT se limite à la génération textuelle, FraudGPT pousse plus loin l’automatisation technique de l’attaque.

Les premiers retours d’utilisateurs de forums spécialisés confirment que FraudGPT est capable d’assister dans l’identification de vulnérabilités, la rédaction de social engineering crédible et même la conception de malwares évasifs. Son absence totale de filtrage, combinée à une interface simple et une communauté d’entraide criminelle active, en fait un outil redoutable. Ce type d’IA met la cybercriminalité à la portée de profils non techniques, tout en rendant les campagnes d’attaques plus crédibles et difficiles à anticiper.

Quelle réponse technique adopter face aux IA offensives comme WormGPT et FraudGPT ?

L’essor des IA génératives utilisées à des fins malveillantes exige une adaptation urgente des outils de cybersécurité. Les attaques produites par des modèles comme WormGPT ou FraudGPT présentent une signature linguistique très proche de celle d’un humain, ce qui complique leur détection par les antivirus traditionnels. Pour y faire face, les équipes doivent adopter des solutions capables d’analyser le comportement global des interactions et non uniquement la nature du code ou du contenu.

Détection de patterns IA dans les journaux système

Une première ligne de défense consiste à intégrer des systèmes capables de repérer les modèles linguistiques anormaux dans les logs d’e-mails, de chat ou d’accès réseau. Certains outils de monitoring avancé ou de SIEM (Security Information and Event Management) utilisent déjà des algorithmes d’analyse sémantique ou syntaxique pour identifier des séquences générées artificiellement. Ces outils peuvent par exemple repérer des séries d’e-mails au style trop homogène ou sans variation naturelle, typiques d’une génération automatique.

SOC IA et EDR comportemental : vers une cybersécurité augmentée

Les EDR (Endpoint Detection and Response) de nouvelle génération misent sur l’intelligence artificielle pour surveiller le comportement des machines et utilisateurs en temps réel. Ils peuvent détecter un changement de schéma d’accès, un exécutable anormalement silencieux ou une séquence d’actions qui évoque une intrusion déguisée. Intégrer ces EDR à un SOC (Security Operations Center) piloté par IA permet une corrélation plus fine entre les alertes et le contexte global, et favorise une réponse rapide en cas de menace.

Les antivirus classiques sont dépassés

Les antivirus basés sur des bases de signatures sont désormais largement inefficaces face aux contenus générés dynamiquement par IA. Un script légèrement modifié par un modèle comme FraudGPT peut passer sous les radars sans déclencher d’alerte. Il est donc essentiel de sortir d’une approche purement réactive, pour s’orienter vers une logique prédictive, capable d’évaluer l’intention ou l’anomalie d’un comportement. Dans ce nouveau paysage, la cybersécurité repose autant sur l’analyse sémantique que sur l’analyse binaire.