Chaque jour, des milliards de pages web sont explorées par des robots invisibles : les crawlers. Ces programmes automatisés, aussi appelés spiders ou bots d’indexation, parcourent sans relâche Internet pour découvrir de nouveaux contenus, analyser les informations qu’ils contiennent et les rendre accessibles via les moteurs de recherche. Sans eux, impossible pour Google, Bing ou Qwant de proposer des résultats pertinents. Mais que sont réellement ces crawlers, comment fonctionnent-ils et quels sont les plus connus ?

Qu’est-ce qu’un crawler ?

Un crawler est un logiciel automatisé conçu pour parcourir le web de manière systématique. Son rôle est d’explorer les pages disponibles en ligne, de collecter leurs contenus et de transmettre ces informations à un moteur de recherche pour qu’elles puissent être indexées.

On retrouve plusieurs appellations pour désigner ce même concept : on parle aussi de spider, de robot ou plus simplement de bot. Quelle que soit la terminologie employée, il s’agit toujours d’un programme qui navigue d’une page à l’autre en suivant les liens hypertextes.

Le fonctionnement global est relativement simple :

- Le crawler découvre une URL (via un sitemap, un lien interne, externe ou un flux RSS).

- Il analyse le contenu de la page (texte, images, balises HTML, données structurées).

- Les informations collectées sont envoyées vers l’index du moteur de recherche, où elles seront stockées et évaluées pour apparaître ou non, dans les résultats proposés aux internautes.

Sans crawlers, les moteurs de recherche n’auraient rien à explorer ni à proposer. Ils sont la première étape indispensable de tout processus d’indexation.

Comment fonctionne un robot d’indexation ?

Un crawler n’est pas un simple script de navigation automatisée : c’est une véritable infrastructure logicielle capable de parcourir, analyser et classer des milliards de documents web en continu. Son fonctionnement repose sur une série d’étapes hiérarchisées, chacune ayant un rôle précis dans la chaîne d’indexation.

1. Les robots d’indexation découvrent de nouvelles URL sur le web

Tout commence par la détection de nouvelles adresses à explorer. Pour ce faire, le crawler s’appuie sur plusieurs sources : les sitemaps XML fournis par les administrateurs de sites, les liens internes reliant les pages d’un même domaine, les liens externes pointant depuis d’autres sites ou encore des flux RSS qui facilitent la détection de contenus fraîchement publiés.

2. Respect des directives d’indexation

En théorie, les crawlers se conforment aux directives inscrites dans le fichier robots.txt et aux balises meta robots (noindex, nofollow). En pratique, seuls les grands acteurs comme Googlebot ou Bingbot respectent scrupuleusement ces règles. De nombreux crawlers tiers (outils SEO, scrapers ou collecteurs de données) ignorent volontairement ces restrictions.

3. Les crawlers explorent et téléchargent les pages web

Une fois les adresses identifiées, le robot procède au téléchargement du contenu associé. Cette opération ne se limite pas au code HTML, le crawler aspire également les feuilles de style CSS, les scripts JavaScript ainsi que les éléments multimédias (images, vidéos, audio). Le but est de reconstituer l’environnement de la page afin d’en percevoir la structure complète à la manière d’un navigateur moderne.

4. Les robots d’indexation analysent la sémantique et la structure du contenu

C’est au cours de cette étape que le crawler révèle toute son utilité. Il procède à une lecture en profondeur du HTML, prend en compte les balises meta (titre, description, directives d’indexation), interprète les contenus médias et déchiffre les données structurées. Cette analyse permet au moteur de recherche de comprendre la thématique, la hiérarchie et la pertinence du contenu.

5. Indexation et actualisation des pages web par les moteurs de recherche

Les informations collectées sont ensuite envoyées vers la base d’indexation du moteur. Une page inédite sera intégrée dans l’index, tandis qu’une page déjà connue sera actualisée si elle a subi des modifications. Cette étape garantit la fraîcheur et la cohérence des résultats affichés aux internautes.

6. Les moteurs de recherche allouent le crawl budget à un site web

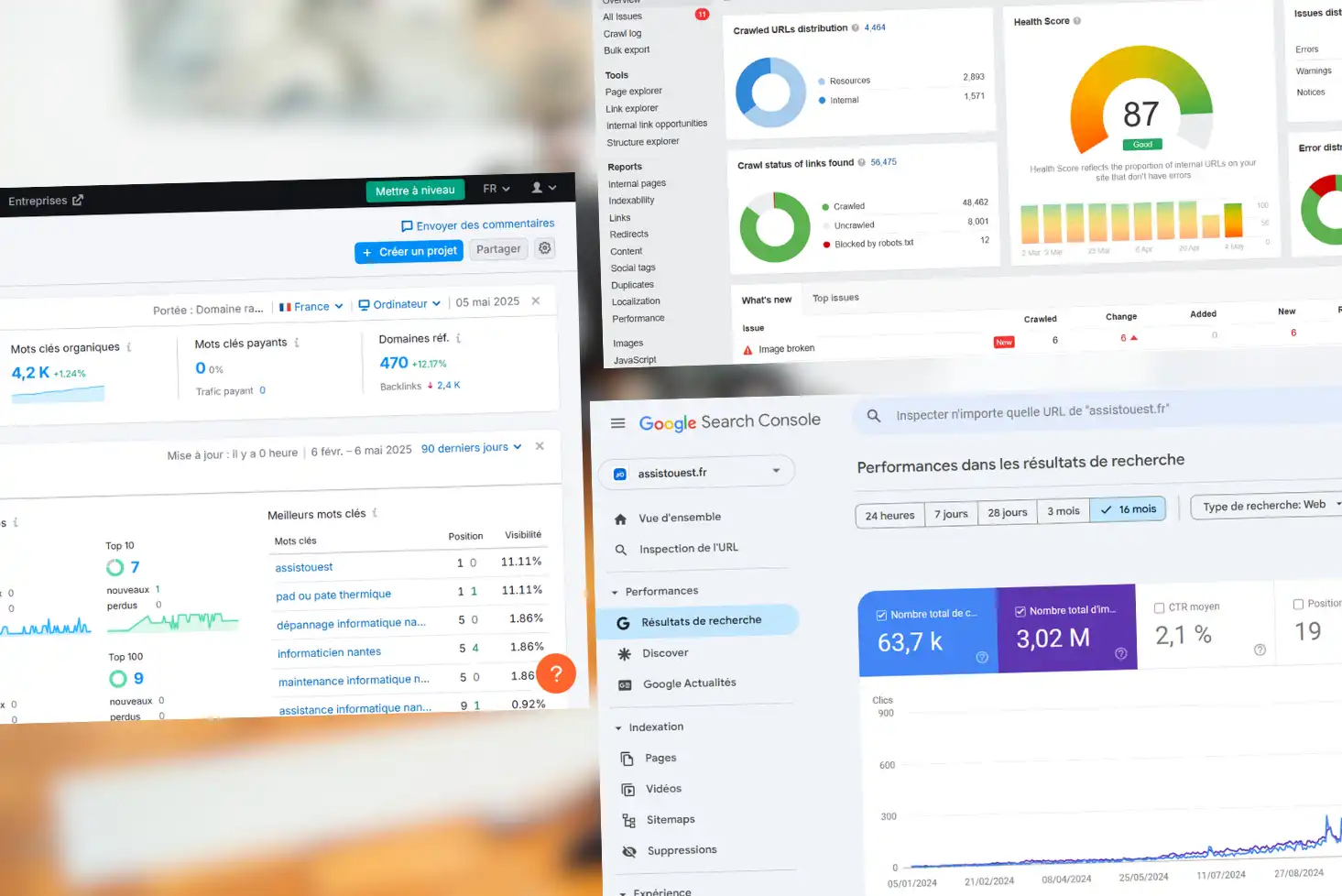

Tous les sites ne bénéficient pas du même niveau d’attention. Chaque domaine se voit attribuer un crawl budget, autrement dit un quota de ressources que le moteur est disposé à consacrer à son exploration. Ce budget dépend de critères multiples : popularité du site, fréquence de mise à jour, qualité perçue du contenu et rapidité de chargement. Plus ces signaux sont positifs, plus le robot reviendra régulièrement.

Découvrez notre formation gratuite en ligne pour apprendre le référencement naturel.

Les différents types de crawlers

Tous les crawlers ne poursuivent pas le même objectif. Derrière ce terme générique se cache une multitude de robots aux usages variés, certains indispensables au référencement naturel, d’autres davantage orientés vers la collecte de données. Voici les principales catégories.

1. Les crawlers des moteurs de recherche

Ce sont les plus connus, ceux qui assurent la visibilité d’un site dans Google, Bing, Yandex, Baidu et autres moteurs. Leurs rôles est d’explorer le web, indexer les pages et maintenir à jour les résultats de recherche. Googlebot ou Bingbot en sont les exemples emblématiques, mais chacun dispose de variantes dédiées (Googlebot-Image, Googlebot-Video, Googlebot-News…).

2. Les crawlers SEO et outils marketing

En marge des moteurs classiques, de nombreux outils d’analyse (Ahrefs, Semrush, Majestic, Moz…) exploitent leurs propres bots pour cartographier le web, analyser les backlinks, mesurer la popularité et détecter des opportunités SEO. Ces robots sont très présents dans les logs serveurs et peuvent parfois générer une charge importante sur les sites.

3. Les crawlers d’archives et d’intelligence artificielle

D’autres acteurs utilisent des crawlers pour constituer d’immenses bases de données ouvertes ou destinées à l’entraînement de modèles d’IA. C’est le cas de l’Internet Archive (Wayback Machine), de Common Crawl ou encore des bots d’OpenAI, Anthropic ou Perplexity. Leur objectif n’est pas l’indexation classique, mais la conservation, l’analyse et l’exploitation des données à grande échelle.

Et les autres types de crawlers

Au-delà des robots des moteurs de recherche, des outils SEO ou des projets d’archivage et d’intelligence artificielle, il existe une multitude d’autres crawlers. Certains sont parfaitement légitimes, comme ceux utilisés par des organismes officiels (ex. autorités de cybersécurité qui surveillent la présence de failles ou de contenus sensibles), ou par des services tiers de veille technologique.

Mais le web attire aussi des robots beaucoup moins bienveillants. Des crawlers malveillants scannent en permanence les sites pour détecter des failles de sécurité, aspirer du contenu, collecter des adresses e-mail ou encore tester des injections SQL. Ces bots n’annoncent pas toujours leur présence et peuvent causer des problèmes de charge serveur, de sécurité ou de vol de données.

Les crawlers sont essentiels au web moderne et au SEO

Les crawlers jouent un rôle central dans le fonctionnement du web moderne. Sans eux, les moteurs de recherche seraient incapables de découvrir de nouvelles pages, d’actualiser leurs index et de proposer des résultats pertinents aux internautes. Comprendre leur logique d’exploration et leurs limites est donc essentiel pour tout propriétaire de site.

Du point de vue du référencement naturel, savoir comment les robots parcourent, analysent et indexent un site permet d’optimiser son architecture, son contenu et sa rapidité d’exécution. C’est également une manière de protéger ses ressources contre les crawlers trop agressifs ou malveillants, qui peuvent nuire aux performances.