Pour la première fois, OpenAI met à disposition deux modèles open-source qui rivalisent avec les meilleurs systèmes actuels. Leur prise en main est étonnamment accessible, car un utilisateur débutant peut désormais les télécharger, les charger et commencer à les utiliser sans aucune configuration complexe. Il faut cependant un ordinateur suffisamment musclé pour gérer leur taille et leur puissance. Cet article vous accompagne pour découvrir ces modèles et les faire fonctionner en local sur Windows.

Utiliser ChatGPT-OSS en local avec les modèles open-weight sur Windows

- OpenAI publie ses premiers modèles open-weight depuis GPT-2

- Utiliser les modèles OpenAI en local avec Ollama sur Windows

- Exécution locale : performances et matériel recommandé

OpenAI publie ses premiers modèles open-weight depuis GPT-2

OpenAI inaugure une nouvelle ère avec la publication de gpt-oss, une famille de modèles open-weight dont les poids sont librement téléchargeables. Ce choix tranche avec la stratégie habituelle de l’entreprise, qui privilégie depuis plusieurs années des modèles accessibles uniquement via son API. Un modèle open-weight n’est pas un modèle open-source au sens strict, car le code d’entraînement et les jeux de données restent privés. En revanche, les poids sont mis à disposition du public, ce qui permet l’exécution locale, la quantisation, l’adaptation à des usages internes et le déploiement sans dépendance au cloud.

Cette ouverture constitue un événement majeur car OpenAI n’avait plus proposé un tel niveau d’accès depuis GPT-2. Elle permet enfin aux développeurs, chercheurs et utilisateurs avancés de manipuler un modèle OpenAI comme n’importe quel LLM de l’écosystème open-source, avec la possibilité de l’intégrer dans des workflows privés et totalement hors-ligne.

| Modèle | Taille | Matériel recommandé | Usage idéal |

|---|---|---|---|

| gpt-oss-20B | ≈ 21 milliards | GPU grand public | Exécution locale sur PC Windows ou Linux |

| gpt-oss-120B | ≈ 117 milliards | Serveurs multi-GPU | Environnements professionnels |

Les premiers résultats et retours indiquent des performances proches de celles d’o3-mini pour les tâches de raisonnement classique. Les deux modèles bénéficient d’un contexte très large pouvant atteindre cent vingt-huit mille tokens, ce qui les rend adaptés aux analyses longues, aux documents complexes et aux agents autonomes.

La rapidité d’inférence constitue également un point fort pour le modèle 20B lorsqu’il est quantisé et exécuté sur un GPU moderne. Comparés aux modèles de référence du marché comme LLaMA 3.1, Mixtral ou Phi-3.5, les gpt-oss se positionnent parmi les solutions les plus avancées dans la catégorie open-weight, tout en offrant une compatibilité technique très large.

Utiliser les modèles OpenAI en local avec Ollama sur Windows

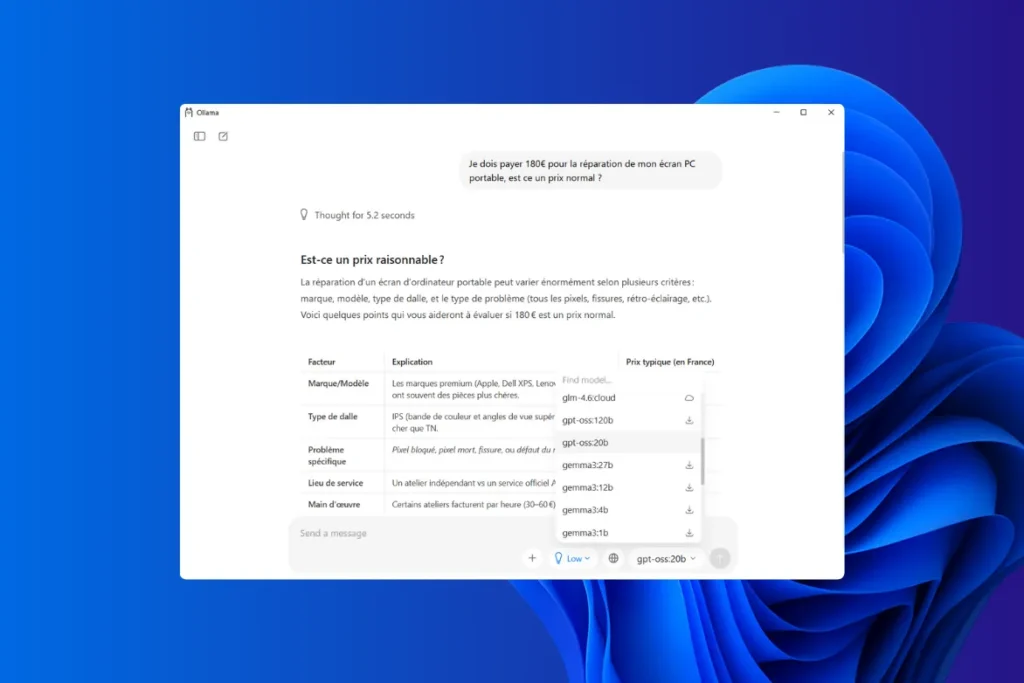

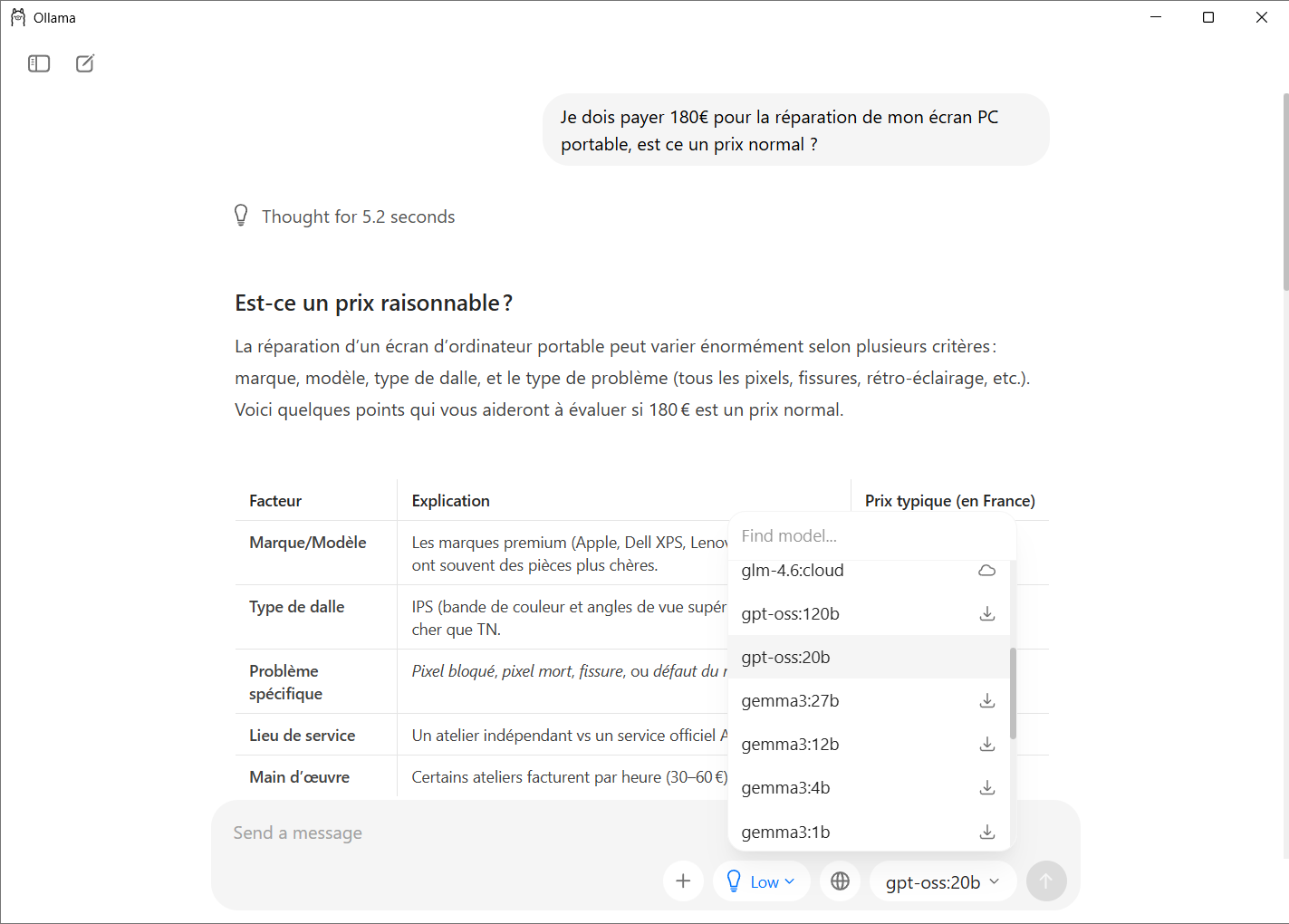

Ollama est aujourd’hui l’outil le plus simple et le plus fiable pour exécuter un modèle OpenAI en local sous Windows. L’application propose une interface graphique qui permet de choisir, télécharger et lancer un modèle sans aucune manipulation technique. L’utilisateur n’a qu’à sélectionner un modèle dans la liste, cliquer pour l’installer et commencer à discuter avec lui dans une fenêtre de type ChatGPT.

Les scripts, applications et outils prévus pour ChatGPT peuvent fonctionner exactement de la même manière en pointant simplement vers l’adresse locale fournie par Ollama. Il n’est donc pas nécessaire de modifier son code ou ses automatisations. Pour un usage courant, aucune ligne de commande n’est requise, ce qui rend l’expérience accessible même à un utilisateur débutant.

- Pour l’utiliser, il suffit de se rendre sur le site officiel d’Ollama et de télécharger l’installateur Windows.

- Une fois lancé, l’assistant configure automatiquement tous les éléments nécessaires et installe le service en arrière-plan qui permettra de charger les modèles à la demande.

Après l’installation, Ollama crée un dossier dédié dans le profil utilisateur pour stocker les modèles téléchargés. Celui-ci est situé dans le répertoire personnel, ce qui facilite la gestion ou la suppression des poids si nécessaire. Ollama intègre un catalogue de modèles directement accessible depuis son interface.

- Pour télécharger gpt-oss, il suffit d’ouvrir l’application et de sélectionner le modèle souhaité dans la liste.

L’outil récupère automatiquement les fichiers nécessaires et les installe sans intervention manuelle. Une fois le modèle présent sur la machine, il apparaît immédiatement comme disponible dans l’interface.

Son utilisation se fait dans une zone de saisie identique à celle d’un chatbot classique. Vous pouvez taper une question ou régler certains paramètres. L’expérience est très proche de celle de ChatGPT, mais entièrement hors-ligne.

Si l’utilisateur souhaite effectuer des recherches web directement depuis l’interface d’Ollama ou utiliser des extensions nécessitant une connexion à Internet, il doit activer une fonction cloud.

Exécution locale : performances et matériel recommandé

L’exécution locale des modèles gpt-oss dépend fortement de la configuration matérielle et de la quantité de VRAM disponible. Plus la VRAM est élevée, plus le modèle peut être chargé directement sur le GPU, ce qui améliore considérablement la vitesse d’inférence et la stabilité. Lorsqu’un modèle ne tient pas entièrement dans le GPU, Ollama bascule automatiquement une partie de la charge en RAM. Cette solution permet de lancer des modèles plus grands que la mémoire vidéo disponible, mais elle augmente le temps de réponse et peut provoquer des erreurs ou des imprécisions lorsque la tension mémoire devient trop importante.

Les exigences varient fortement entre gpt-oss-20B et gpt-oss-120B. Le premier peut fonctionner sur un PC gamer récent grâce aux quantisations, tandis que le second est réservé à des infrastructures professionnelles avec plusieurs dizaines de gigaoctets de VRAM.

| Modèle | FP16 | Q8 | Q5 | Q4 |

|---|---|---|---|---|

| gpt-oss-20B | 30–40 Go | 18–22 Go | 10–12 Go | 8 Go |

| gpt-oss-120B | 150+ Go | 90 Go | — | — |

Si votre PC n’est pas assez puissant, il existe des modèles plus adaptés, découvrez les meilleurs modèles et logiciels pour faire tourner une IA local sur Windows.

L’exécution locale peut être nettement améliorée en appliquant quelques bonnes pratiques, surtout lorsque la VRAM n’est pas optimale.

Choisir la quantisation Q4 sur un petit GPU

Ce format offre l’un des meilleurs compromis entre vitesse et qualité. Il permet de faire tenir gpt-oss-20B sur une carte graphique milieu de gamme tout en conservant un niveau de précision acceptable. En dessous de Q4, les erreurs deviennent plus fréquentes et le modèle peut produire des incohérences.

Privilégier le GPU plutôt que le CPU

Même si Ollama peut utiliser la RAM et le CPU pour compléter la charge, les performances chutent rapidement dès que le modèle quitte la VRAM. Plus le GPU prend en charge la totalité des poids ou une grande majorité, plus la génération sera rapide, stable et fiable.

Utiliser le multi-GPU sous Linux pour les modèles géants

Le modèle gpt-oss-120B nécessite un environnement multi-GPU ou un serveur doté d’une VRAM extrêmement élevée. Sous Linux, la répartition automatique des blocs du modèle entre plusieurs cartes graphiques permet d’exploiter ce type de modèles dans un cadre professionnel.

Sources et ressources

- The verge - OpenAI’s open language model is imminent