Pour la première fois depuis 2019, OpenAI publie des modèles de langage à poids ouverts. Baptisés GPT-OSS, ces deux modèles viennent marquer un tournant stratégique pour l’entreprise, longtemps critiquée pour son virage fermé. Entre architecture Mixture of Experts, performances comparables aux modèles propriétaires et licence Apache 2.0, OpenAI tente de réintégrer l’open source sans renoncer à sa domination.

GPT-OSS 120B : OpenAI revient à l’open source avec un MoE de 120 milliards de paramètres

- OpenAI publie deux modèles open source

- GPT-OSS signe le retour de l’open source dans la vision d’OpenAI

OpenAI publie deux modèles open source

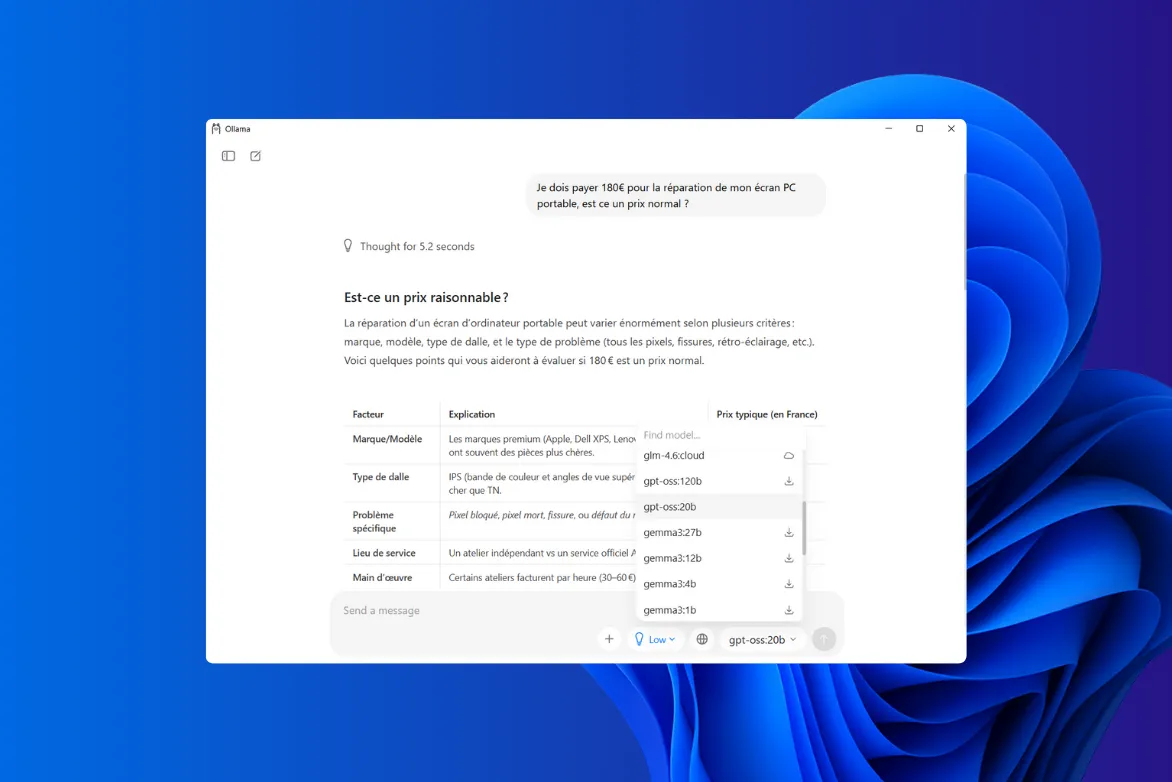

OpenAI ne s’est pas contenté d’ouvrir un modèle, mais en propose deux sous le label GPT-OSS. Chacun répond à des besoins différents et illustre une stratégie technique bien pensée : une version dense plus accessible, et une version massive exploitant les avancées du Mixture of Experts (MoE).

GPT-OSS-12B : le modèle dense

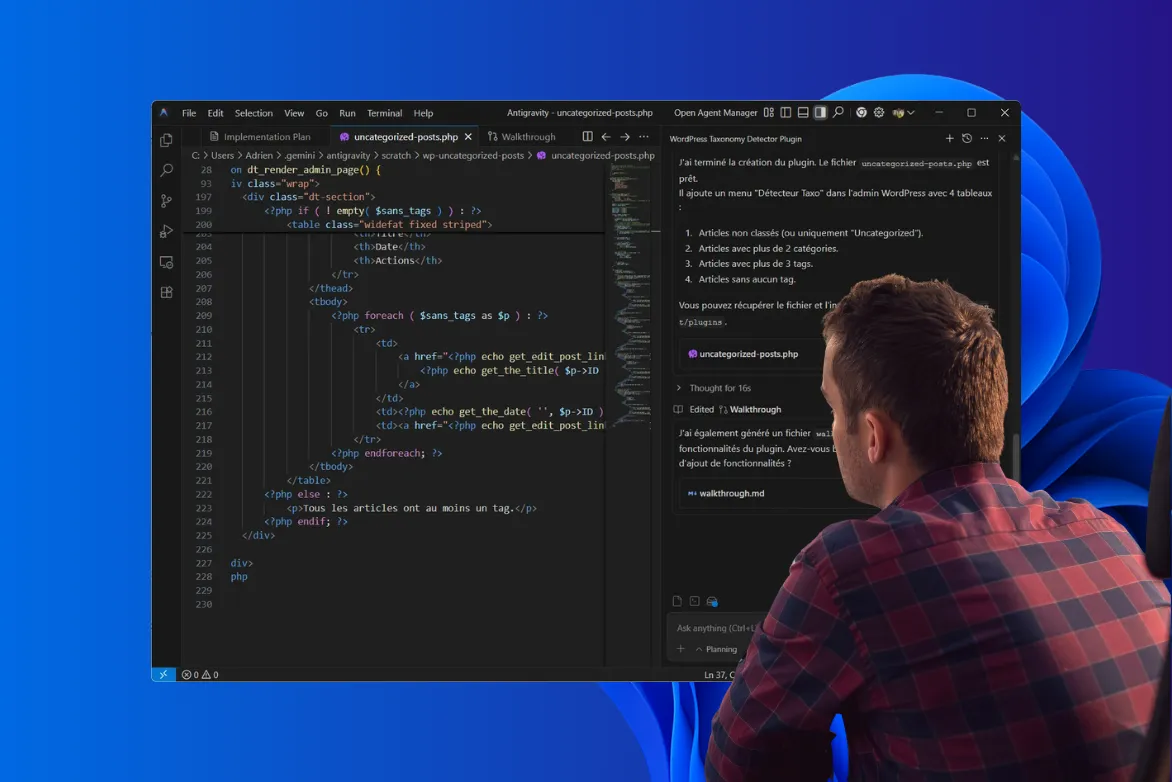

Le premier modèle GPT-OSS-12B est un modèle dense de 12 milliards de paramètres. Il adopte une architecture classique de type Transformer, sans experts ni sous-réseaux dynamiques. Conçu pour être facilement intégrable dans des infrastructures locales ou cloud classiques, il offre une bonne balance entre performance et coût de déploiement.

Ce modèle vise clairement les chercheurs, les développeurs et les entreprises qui cherchent un compromis entre accessibilité, rapidité d’inférence et qualité de génération. Il se prête bien à des cas d’usage comme les chatbots spécialisés, la génération de code ou les assistants embarqués à faible latence.

GPT-OSS-120B : le modèle Mixture of Experts (MoE)

Le second modèle GPT-OSS-120B est beaucoup plus ambitieux. Il repose sur une architecture Mixture of Experts avec 128 experts par couche dont seulement 4 sont activés à chaque token. Cela signifie que malgré ses 120 milliards de paramètres théoriques, seuls environ 12 à 15 milliards sont réellement utilisés pour chaque prédiction, ce qui permet de maintenir une efficacité computationnelle étonnamment élevée.

Avec ses 36 couches, un contexte étendu à 128 000 tokens et des performances rivalisant avec des modèles propriétaires comme GPT-4 mini, GPT-OSS-120B se positionne comme un modèle haut de gamme open source. Il est destiné aux applications lourdes en calcul, à la recherche avancée ou à des projets industriels nécessitant une IA puissante mais déployable hors des services propriétaires d’OpenAI.

| Modèle | Niveaux | Nombre total de paramètres | Paramètres actifs par jeton | Nombre total d’experts | Experts actifs par jeton | Longueur du contexte |

| gpt-oss-120b | 36 | 117 milliards | 5,1 milliards | 128 | 4 | 128 000 |

| gpt-oss-20b | 24 | 21 milliards | 3,6 milliards | 32 | 4 | 128 000 |

Ces deux modèles sont disponibles sous licence Apache 2.0, téléchargeables librement et compatibles avec les principaux frameworks open source. OpenAI signe ainsi son grand retour dans l’écosystème open source avec des modèles capables de rivaliser avec les meilleurs du moment.

GPT-OSS signe le retour de l’open source dans la vision d’OpenAI

Avec GPT‑OSS, OpenAI signe un retour remarqué dans l’univers open source. Après des années de fermeture croissante depuis GPT‑3, l’entreprise ouvre enfin l’accès à des modèles puissants, performants et utilisables librement. C’est un tournant symbolique, dans un contexte où la concurrence pousse à davantage de transparence et d’ouverture.

En publiant GPT‑OSS‑12B et GPT‑OSS‑120B sous licence Apache 2.0, OpenAI cherche à regagner la faveur des développeurs, des chercheurs et des entreprises désireuses de garder le contrôle sur leurs outils IA. Cela redonne à l’open source une place légitime dans la vision d’une intelligence artificielle distribuée, flexible et auditable.

Reste maintenant à voir si cette ouverture saura séduire dans les faits. Les modèles seront-ils adoptés massivement, forkés, améliorés ? Ou bien relégués à un rôle d’alibi technique dans une stratégie toujours centrée sur l’API payante ? La balle est désormais dans le camp de la communauté. Et peut-être aussi dans celui des clouds européens, des startups IA locales et de tous ceux qui attendaient ce moment depuis 2019.

Sources et ressources

- Open AI - Lancement de gpt-oss